Sissejuhatus Hadoopi raamistikku

Enne kui sügavalt Hadoopi tehnilisse raamistikku sukeldume, alustame lihtsa näitega.

On talu, mis koristab tomateid ja ladustab neid ühes hoiupaigas. Nüüd, kus suurenev köögiviljavajadus, hakkas farm koristama kartuleid, porgandeid - kasvava nõudlusega oli põllumeestest puudus, mistõttu nad palkasid rohkem põllumehi. Mõne aja pärast mõistsid nad, et ladustamisalal on puudus - seega jagasid nad köögivilju erinevatesse ladustamiskohtadesse. Andmete hankimisel töötavad kõik paralleelselt oma salvestusruumiga.

Kuidas see lugu on suurandmetega seotud?

Varem oli meil piiratud töötleja ja ühe salvestusüksusega andmeid. Kuid siis suurenes andmete genereerimine, mis viis suure mahu ja erinevate sortideni - struktureeritud, poolstruktureeritud ja struktureerimata. Nii et lahendus oli kasutada iga protsessori jaoks hajutatud salvestusruumi, mis võimaldas hõlpsat juurdepääsu andmete talletamiseks ja neile juurde pääseda.

Nüüd saame köögiviljad asendada erinevat tüüpi andmete ja salvestuskohana kui jagatud andmete säilitamise kohad ja erinevad töötlejad - töötlejad.

Nii et suured andmed on väljakutse ja Hadoop mängib lahenduse osa.

HADOOP

1. Lahendus BIG DATA-le: kuna see tegeleb suure mahu, kiiruse ja andmete mitmekesisusega.

2. Avatud lähtekoodiga projekti komplekt.

3. Salvestab tohutult andmemahtu usaldusväärselt ja võimaldab tohutult hajutatud arvutusi.

4. Hadoopi peamised atribuudid on koondamine ja usaldusväärsus (absoluutselt andmete kadu).

5. Keskendub peamiselt partiide töötlemisele.

6. Töötab kauba riistvara peal - te ei pea ostma spetsiaalset kallist riistvara.

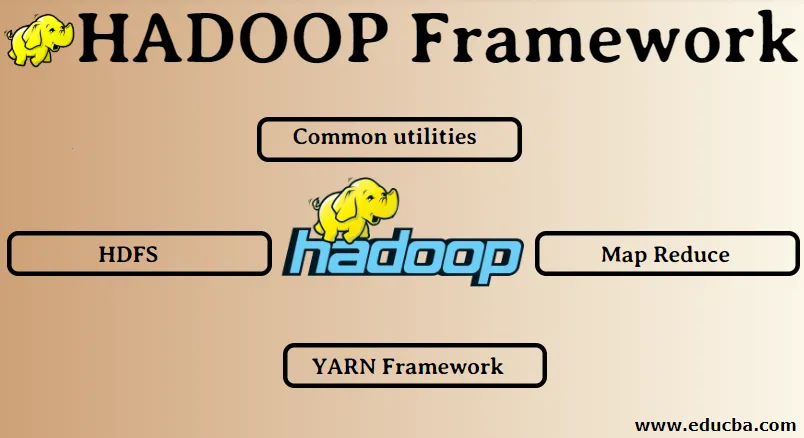

Hadoopi raamistik:

1. Ühised kommunaalkulud

2. HDFS

3. Kaardi vähendamine

4. Lõnga raamistik

1. Ühised kommunaalkulud:

Seda nimetatakse ka Hadoopi harilikuks. Need pole muud kui JAVA teegid, failid, skriptid ja utiliidid, mida tegelikult peavad Hadoopi muud komponendid tegema.

2. HDFS: Hadoopi hajutatud failisüsteem

Miks Hadoop otsustas lisada hajutatud failisüsteemi?

Saame sellest aru näitega: peame lugema 1TB andmeid ja meil on üks masin, millel on 4 I / O kanalit, igal kanalil on 100 MB / s, kogu andmete lugemiseks kulus 45 minutit. Nüüd loeb sama palju andmeid 10 masinat, igas 4 sisend / väljundkanalit, igal kanalil 100 MB / s. Kas arvate, kui palju aega andmete lugemiseks kulus? 4, 3 minutit. HDFS lahendab suurandmete salvestamise probleemi. HDFS-i kaks peamist komponenti on NAME NODE ja DATA NODE. Nimesõlm on ülem, võib meil olla ka teisene nimesõlm, kui primaarne nimesõlm enam ei tööta, toimib teisene nimesõlm varukoopiana. Nimesõlm põhimõtteliselt hooldab ja haldab andmesõlmi, talletades metaandmeid. Andmesõlm on ori, mis on põhimõtteliselt odava kauba riistvara. Meil võib olla mitu andmesõlme. Andmesõlm salvestab tegelikud andmed. See andmesõlm toetab replikatsioonifaktorit. Oletame, et kui üks andmesõlm läheb alla, pääseb andmetele juurde teine kopeeritud andmesõlm, seetõttu on andmete juurdepääsetavus paranenud ja andmete kadumine on välistatud.

3. Kaardi vähendamine:

See lahendab suurandmete töötlemise probleemi. Saame aru mõiste kontseptsioon vähendab, lahendades selle reaalse maailma probleem. ABC ettevõte soovib arvutada kogu müügi linna järgi. Nüüd siin räsitabeli kontseptsioon ei tööta, kuna andmed on terabaitides, seega kasutame mõistet Map-Reduce.

Seal on kaks etappi: a) MAP. b) VÄHENDADA

a) Kaart : kõigepealt jaotame andmed võtme / väärtuse paari põhjal väiksemateks tükkideks, mida nimetatakse kaardistajateks. Nii saab siin võtmeks linna nimi ja väärtus on kogu müük. Iga kaardistaja saab iga kuu andmed, mis annavad linna nime ja vastava müügi.

b) Vähenda: see saab need andmehunnikud ja iga reduktor vastutab põhja / lääne / ida / lõuna linnade eest. Nii kogub reduktori töö neid väikeseid tükke ja kogub need konkreetse linna jaoks suuremateks kogusteks (lisades need kokku).

4.YARN-i raamistik: veel üks ressursiläbirääkija.

Hadoopi algsel versioonil oli vaid kaks komponenti: Map Reduce ja HDFS. Hiljem saadi aru, et Map Reduce ei suuda lahendada paljusid suuri andmeprobleeme. Idee oli võtta ressursside haldamise ja töö planeerimisega seotud kohustused vanast kaardivähendamismootorist eemale ja anda see uuele komponendile. Nii et YARN sattus pildile. Klastriressursside haldamise eest vastutab HDFS ja Map Reduce vaheline keskmine kiht.

Sellel on kaks võtmerolli: a) töö planeerimine. b) ressursside juhtimine

a) Töögraafik: kui töötlemiseks on vaja palju andmeid, tuleb see jagada ja jagada erinevateks ülesanneteks / töödeks. Nüüd otsustab ühine sekretariaat, millisele tööle tuleb anda esmatähtis prioriteet, kahe töökoha vaheline ajavahemik, sõltuvus töökohtade vahel ja kontrollib, kas töötavad töökohad ei kattu.

b) ressursside haldamine: andmete töötlemiseks ja säilitamiseks vajame ressursse? Nii pakub, haldab ja hooldab ressursside haldur ressursse andmete salvestamiseks ja töötlemiseks.

Nüüd on Hadoopi kontseptsioon selge ja kuidas see lahendab BIG DATA loodud väljakutseid !!!

Soovitatavad artiklid

See on olnud Hadoopi raamistiku juhend. Siin oleme arutanud ka Hadoopi 4 parimat raamistikku. Lisateavet leiate ka meie muudest soovitatud artiklitest -

- Hadoopi andmebaas

- Hadoopi ökosüsteem

- Hadoopi kasutusviisid

- Hadoopi administraatori töökohad

- Hadoopi administraator | Oskused ja karjääritee