Hadoopi installimise ülevaade

Järgmine artikkel Hadoopi installimine annab ülevaate Hadoopi levinumatest raammoodulitest ja Hadoopi järkjärgulisest installimisest. Apache Hadoop on tarkvarakogum, mis võimaldab töödelda suuri andmekogumeid ja jaotatud salvestusruumi erinevat tüüpi arvutisüsteemi klastrites. Praegu on Hadoop laialdasemalt kasutatav suurandmete analüüsi platvorm („Sanchita Lobo, Analyticsi koolitusblogi autor”).

Hadoopi raamistik

Apache Hadoopi raamistik koosneb järgmistest võtmemoodulitest.

- Apache Hadoop ühine.

- Apache Hadoopi hajutatud failisüsteem (HDFS).

- Apache Hadoop MapReduce

- Apache Hadoop YARN (veel üks ressursihaldur).

Apache Hadoop ühine

Apache Hadoop Common moodul koosneb jagatud raamatukogudest, mida kasutatakse kõigi muude moodulite jaoks, sealhulgas võtmehaldus, üldised I / O-paketid, meetrikakogu teegid ning registri, turbe ja voogesituse utiliidid.

HDFS

HDFS põhineb Google'i failisüsteemil ja on üles töötatud odava riistvaraga töötamiseks. HDFS talub rikkeid ja on mõeldud rakenduste jaoks, millel on suured andmekogumid.

MapReduce

MapReduce on loomulik andmetöötluse paralleelne programmeerimismudel ja Hadoop saab käivitada MapReduce'i programme, mis on kirjutatud erinevates keeltes, näiteks Java. MapReduce jagab töötlemise kaardifaasiks ja vähendab faasi.

Apache Hadoopi lõng

Apache Hadoop YARN on põhikomponent ning ressursside haldamise ja tööde ajastamise tehnoloogia Hadoopi hajutatud töötlemisraamistikus.

Selles artiklis käsitleme Hadoopi 2.7.4 installimist ja konfigureerimist ühe sõlme klastrisse ja testime konfiguratsiooni, käivitades MapReduce'i programmi, mida nimetatakse wordcount, et arvutada failis olevate sõnade arv. Järgnevalt vaatleme mõnda olulist Hadoopi failisüsteemi käsku.

Hadoopi installimise sammud

Järgnev on kokkuvõte Apache Hadoopi konfigureerimisega seotud ülesannetest.

1. ülesanne: Hadoopi installimise esimene ülesanne hõlmas virt OS-i malli seadistamist, mis oli konfigureeritud Cent OS7-ga. Hadoopi käitamiseks vajalikud paketid nagu Java SDK 1.8 ja Runtime Systems laaditi alla ja Java keskkonnamuutuja Hadoopi jaoks konfigureeriti redigeerimisega bash_rc.

Ülesanne 2: pakett Hadoop Release 2.7.4 laaditi alla apache veebisaidilt ja ekstraheeriti opt-kausta. Seejärel nimetati see hõlpsa juurdepääsu saamiseks Hadoopiks.

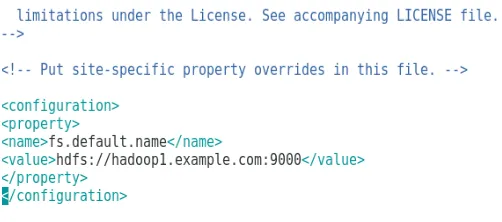

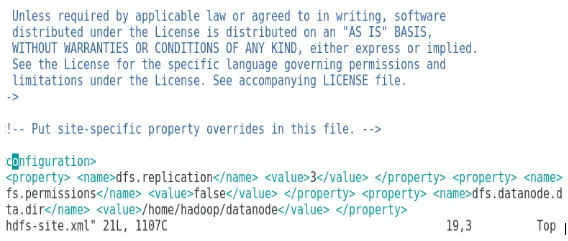

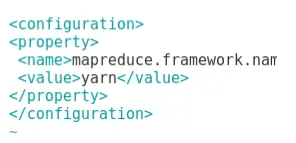

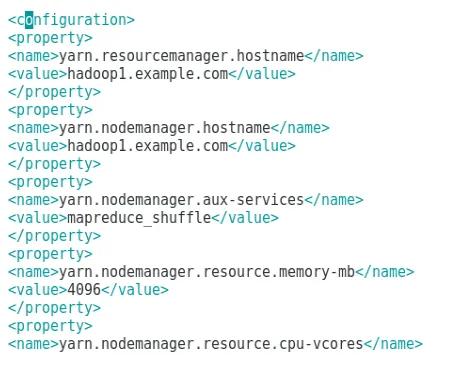

Ülesanne 3: Pärast Hadoopi pakettide ekstraheerimist hõlmas järgmine samm keskkonnamuutuja konfigureerimist Hadoopi kasutaja jaoks, millele järgnes Hadoopi sõlme XML-failide konfigureerimine. Selles etapis konfigureeriti nimi NameNode saidil core-site.xml ja DataNode saidil hdfs-site.xml. Ressursihaldur ja sõlmehaldur olid konfigureeritud lõngas-site.xml.

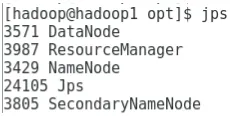

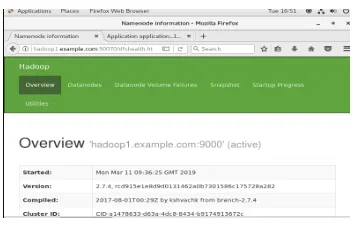

Ülesanne 4: tulemüür YARN ja DFS käivitamiseks keelati. JPS-i käsu abil kontrolliti, kas vastavad deemonid töötavad taustal. Hadoopi pääsemiseks mõeldud pordi number konfigureeriti aadressile http: // localhost: 50070 /

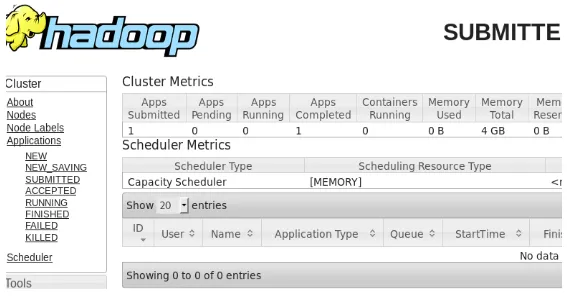

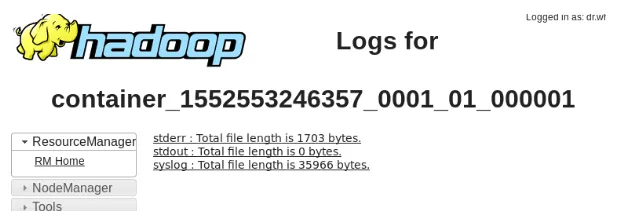

5. ülesanne: Hadoopi kontrollimiseks ja testimiseks kasutati järgmisi paari sammu. Selleks oleme WordCount programmi jaoks sisestuskataloogis loonud ajutise testfaili. Kaardi vähendamise programmi Hadoop-MapReduce-example2.7.4.jar kasutati failis olevate sõnade arvu loendamiseks. Tulemusi hinnati localhostis ja analüüsiti esitatud taotluse logisid. Kõiki esitatud MapReduce'i taotlusi saab veebipõhises liideses vaadata, vaikimisi kasutatava pordi number on 8088.

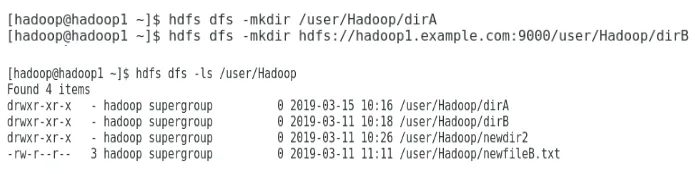

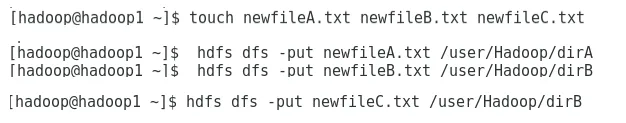

Ülesanne 6: Viimases ülesandes tutvustame Hadoopi failisüsteemi põhilisi käske ja kontrollime nende kasutamist. Näeme, kuidas saab Hadoopi failisüsteemis kataloogi luua, et loetleda kataloogi sisu, selle suurus baitides. Veel näeme, kuidas konkreetset kataloogi ja faili kustutada.

Tulemused Hadoopi installimises

Järgnevas on toodud kõigi ülaltoodud ülesannete tulemused:

1. ülesande tulemus

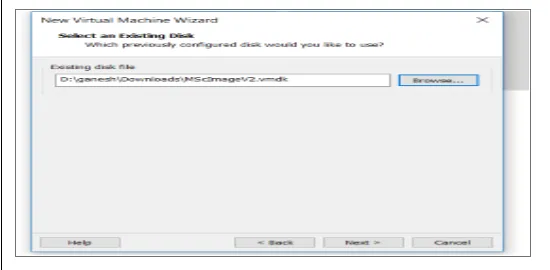

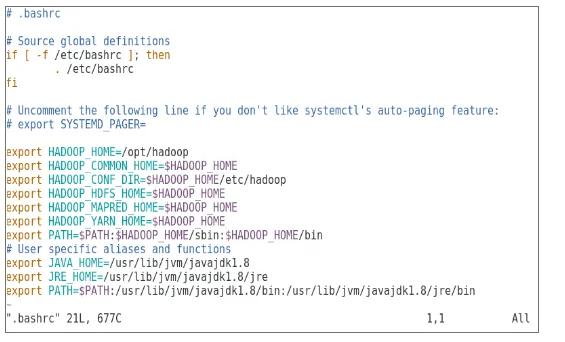

Apache Hadoopi käitamiseks on konfigureeritud uus virtOS, millel on cenOS7 pilt. Joonis 1 näitab, kuidas CenOS 7 pilt virtuaalmasinas konfigureeriti. Joonis 1.2 näitab JAVA keskkonnamuutuja konfiguratsiooni .bash_rc piires.

Joonis 1: Virtuaalmasina konfiguratsioon

Joonis 1.2: Java keskkonnamuutuja konfiguratsioon

2. ülesande tulemus

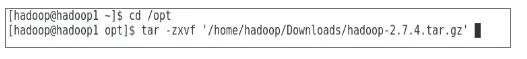

Joonis 2 näitab Hadoop 2.7.4 paketi kausta valimiseks väljapakutud toimingut.

Joonis 2: Hadoop 2.7.4 pakendi ekstraheerimine

3. ülesande tulemus

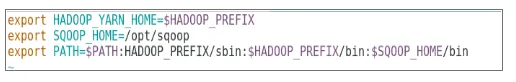

Joonis 3 näitab Hadoopi kasutaja jaoks keskkonnamuutuja konfiguratsiooni, joonised 3.1 kuni 3.4 - Hadoopi konfigureerimiseks vajalike XML-failide konfiguratsiooni.

Joonis 3: Keskkonnamuutuja konfigureerimine Hadoopi kasutaja jaoks

Joonis 3.1: core-site.xml seadistamine

Joonis 3.2: hdfs-site.xml seadistamine

Joonis 3.3: kaardistatud saidi.xml-faili konfigureerimine

Joonis 3.4: faili yarn-site.xml konfigureerimine

4. ülesande tulemus

Joonis 4 näitab jps-käsu kasutamist taustal töötavate asjakohaste deemonite kontrollimiseks ja järgnev joonis näitab Hadoopi veebiliidese kasutamist.

Joonis 4: jps-käsk jooksvate deemonite kontrollimiseks.

Joonis 4.1: Juurdepääs Hadoopi veebiliidesele sadamas http://hadoop1.example.com:50070/

5. ülesande tulemus

Joonis 5 näitab MapReduce'i programmi tulemust nimega wordcount, mis loendab sõnade arvu failis. Järgmisel paaril joonisel on esitatud ülesande YARN ressursihalduri veebiliides.

Joonis 5: MapReduce'i programmi tulemused

Joonis 5.1: esitatud kaardi vähendamise rakendus.

Joonis 5.2: esitatud MapReduce'i rakenduse logid.

6. ülesande tulemus

Joonis 6 näitab, kuidas Hadoopi failisüsteemis kataloog luua ja hdfs-kataloogi loetleda.

Joonis 6: kataloogi loomine Hadoopi failisüsteemis

Joonis 6.1 näitab, kuidas faili Hadoopi hajutatud failisüsteemi üles panna ja joonis 6.2 näitab loodud faili kataloogis kataloog.

Joonis 6.1: faili loomine HDFS-is.

Joonis 6.2: Uus fail on loodud.

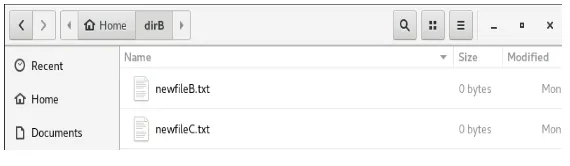

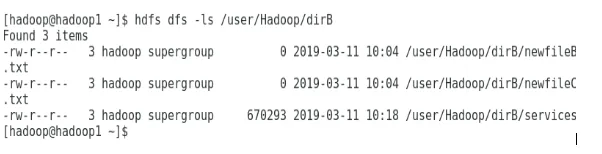

Järgmised joonised näitavad, kuidas konkreetsete kataloogide sisu loetleda:

Joonis 6.3: dirA sisu

Joonis 6.4: dirB sisu

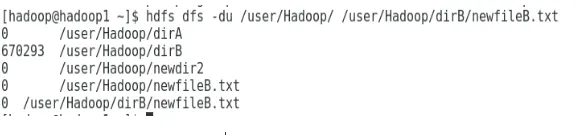

Järgmine joonis näitab, kuidas faili ja kataloogi suurust saab kuvada:

Joonis 6.5: faili ja kataloogi suuruse kuvamine.

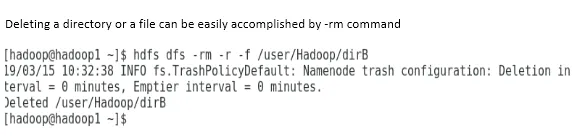

Kataloogi või faili kustutamist saab hõlpsalt teha -rm käsuga.

Joonis 6.6: faili kustutamine.

Järeldus

Big Data on tänase maailmaturu kujundamisel mänginud väga olulist rolli. Hadoopi raamistik muudab andmeanalüütiku elu lihtsaks, töötades samal ajal suurte andmekogumitega. Apache Hadoopi konfigureerimine oli üsna lihtne ja veebipõhine kasutajaliides pakkus kasutajale rakenduse häälestamiseks ja haldamiseks mitmeid võimalusi. Hadoopi on organisatsioonides massiliselt kasutatud andmete salvestamiseks, masinõppe analüüsi tegemiseks ja andmete varundamiseks. Suure hulga andmete haldamine on Hadoopi hajutatud keskkonna ja MapReduce'i tõttu olnud üsna mugav. Hadoopi areng oli suhteliste andmebaasidega võrreldes üsna hämmastav, kuna neil puuduvad häälestamis- ja jõudlusvalikud. Apache Hadoop on kasutajasõbralik ja odav lahendus suurandmete tõhusaks haldamiseks ja säilitamiseks. HDFS aitab andmete salvestamisel ka kaugele jõuda.

Soovitatavad artiklid

See on Hadoopi installimise juhend. Siin käsitleme Instal Hadoopi sissejuhatust, Hadoopi järkjärgulist installimist koos Hadoopi installimise tulemustega. Lisateavet leiate ka meie muudest soovitatud artiklitest -

- Hadoopi voogesituse sissejuhatus

- Mis on Hadoopi klaster ja kuidas see töötab?

- Apache Hadoopi ökosüsteem ja selle komponendid

- Millised on Hadoopi alternatiivid?