Erinevus Hadoop vs Spark vahel

Hadoop on avatud lähtekoodiga raamistik, mis võimaldab suurandmeid salvestada ja töödelda hajutatud keskkonnas arvutiklastrite vahel. Hadoop on loodud suurendamiseks ühest serverist tuhandetesse masinatesse, kus iga masin pakub kohalikku arvutamist ja salvestust. Spark on avatud lähtekoodiga klastrite arvuti, mis on loodud kiireks arvutamiseks. See pakub liidest tervete klastrite programmeerimiseks koos kaudse andmete paralleelsuse ja rikketolerantsiga. Sparki peamine omadus on mälusisene klastrite arvutamine, mis suurendab rakenduse kiirust.

Hadoop

- Hadoop on tarkvara sihtasutuse Apache registreeritud kaubamärk. See kasutab klastrite vahel vajaliku toimingu teostamiseks lihtsat programmeerimismudelit. Kõik Hadoopi moodulid on loodud põhimõttelise eeldusega, et riistvaratõrked on tavalised juhtumid ja nendega peaks tegelema raamistik.

- See käivitab rakenduse, kasutades MapReduce'i algoritmi, kus andmeid töödeldakse paralleelselt erinevatel protsessori sõlmedel. Teisisõnu, Hadoopi raamistik on piisavalt võimeline arendama rakendusi, mis on lisaks võimelised töötama arvutiklastrites ja nad saaksid tohutu hulga andmete jaoks teha täieliku statistilise analüüsi.

- Hadoopi tuum koosneb salvestusosast, mida tuntakse Hadoopi hajutatud failisüsteemina, ja töötlemisosast, mida nimetatakse MapReduce'i programmeerimismudeliks. Põhimõtteliselt jagab Hadoop failid suurtesse plokkidesse ja jaotab need klastritesse, edastab paketi koodi sõlmedes, et andmeid paralleelselt töödelda.

- Selle lähenemisviisi andmestikku töödeldakse kiiremini ja tõhusamalt. Muud Hadoopi moodulid on Hadoopi ühised, mis on hulgaliselt Java-teegid ja utiliidid, mille Hadoopi moodulid tagastavad. Need teegid pakuvad failisüsteemi ja opsüsteemi taseme abstraktsiooni, sisaldavad ka vajalikke Java-faile ja skripte Hadoopi käivitamiseks. Hadoopi lõng on ka moodul, mida kasutatakse töö kavandamiseks ja klastriressursside haldamiseks.

Säde

- Spark ehitati Hadoopi MapReduce mooduli ülaosale ja see laiendab MapReduce mudelit, et tõhusamalt kasutada rohkem tüüpi arvutusi, mis hõlmavad interaktiivseid päringuid ja voo töötlemist. Spark võeti kasutusele Apache tarkvara sihtasutuse poolt, et kiirendada Hadoopi arvutustehnikat.

- Sparkil on oma klastrihaldus ja see pole Hadoopi modifitseeritud versioon. Spark kasutab Hadoopi kahel viisil - üks on ladustamine ja teine töötlemine. Kuna klastrihaldus on pärit Sparkist, kasutab ta Hadoopi ainult ladustamiseks.

- Spark on üks Hadoopi alamprojektidest, mis töötati välja 2009. aastal, ja hiljem sai see BSD litsentsi alusel avatud lähtekoodina. Sellel on palju suurepäraseid funktsioone, muutes teatud mooduleid ja kaasates uusi mooduleid. See aitab käivitada rakendust Hadoopi klastris, mitu korda kiiremini mälus.

- See on võimalik tänu kettale lugemise / kirjutamise toimingute arvu vähendamisele. See salvestab andmete töötlemise vahemällu mällu, salvestades lugemis- ja kirjutamisoperatsioonid. Spark pakub ka sisseehitatud API-sid Java, Python või Scala. Seega saab rakendusi kirjutada mitmel viisil. Spark ei paku mitte ainult strateegiat Map ja Reduce, vaid toetab ka SQL päringuid, voogesituse andmeid, masinõpet ja graafikute algoritme.

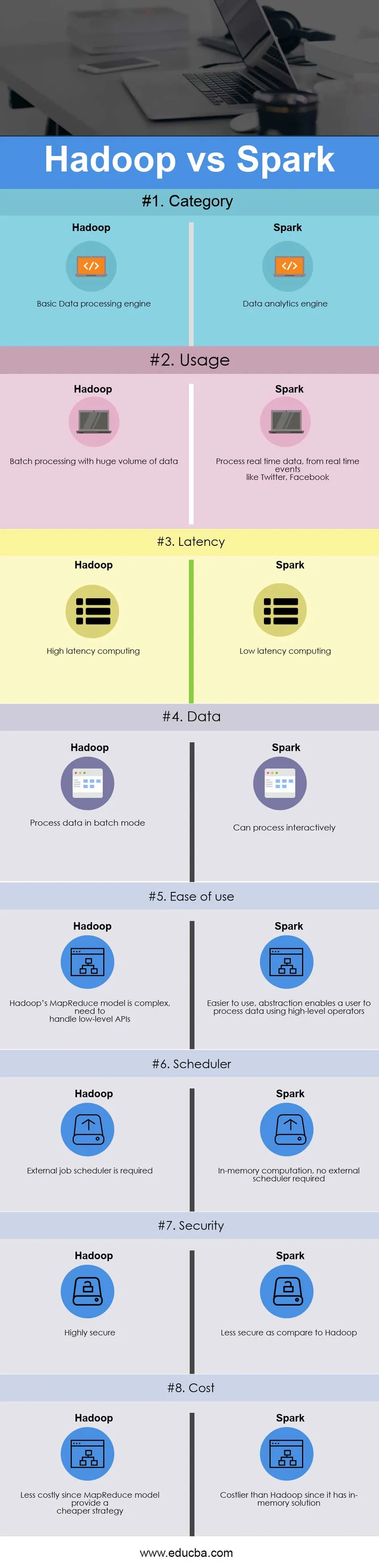

Pea ja pea võrdlus Hadoopi ja Sparki vahel (infograafika)

Allpool on 8 suurimat erinevust Hadoop vs Spark

Peamised erinevused Hadoop vs Spark vahel

Mõlemad Hadoop vs Spark on turul populaarsed valikud; arutame mõnda peamist erinevust Hadoopi ja Sparki vahel:

- Hadoop on avatud lähtekoodiga raamistik, mis kasutab MapReduce'i algoritmi, samas kui Spark on välkkiire klastrite arvutustehnoloogia, mis laiendab MapReduce'i mudelit, et seda saaks tõhusamalt kasutada teist tüüpi arvutustes.

- Hadoopi MapReduce'i mudel loeb ja kirjutab kettalt, aeglustades seega töötlemiskiirust, samas kui Spark vähendab lugemis- / kirjutamistsüklite arvu kettale ja vahemäluseadmete salvestamist mällu, seega kiiremat töötlemiskiirust.

- Hadoop nõuab arendajatelt iga toimingu käsitsi kodeerimist, samas kui Sparkit on RDD - elastse hajutatud andmestiku abil lihtne programmeerida.

- Hadoopi MapReduce'i mudel pakub pakettmootorit, sõltuvalt muudest nõuetest erinevatest mootoritest, samas kui Spark täidab paketis, interaktiivselt, masinõppena ja voogesitusega kõik samas klastris.

- Hadoop on loodud pakkide töötlemise tõhusaks käitlemiseks, samas kui Spark on loodud reaalajas andmete tõhusaks töötlemiseks.

- Hadoop on kõrge latentsusajaga andmetöötlusraamistik, millel puudub interaktiivne režiim, samas kui Spark on madala latentsusajaga andmetöötlus ja suudab andmeid interaktiivselt töödelda.

- Hadoopi MapReduce'i abil saab arendaja andmeid töödelda ainult pakkimisrežiimis, samas kui Spark saab töödelda reaalajas andmeid Sparki voogesituse kaudu.

- Hadoop on loodud rikete ja tõrgete käsitlemiseks, see on loomulikult vea suhtes vastupidav, seega väga tõrketaluvusega süsteem, samas kui Sparki puhul võimaldab RDD partitsioonide taastamist ebaõnnestunud sõlmedel.

- Hadoop vajab näiteks välist tööde planeerijat - Oozie keerukate voogude ajastamiseks, samas kui Sparkil on mälusisene arvutus, nii et tal on oma vooluajasti.

- Hadoop on odavam variant, kui võrrelda seda kulude osas, samas kui Spark nõuab mälu käivitamiseks palju RAM-i, suurendades seeläbi klastrit ja seega ka kulusid.

Hadoop vs Spark võrdlustabel

Allpool käsitletakse peamist Hadoopi ja Sparki võrdlust

| Hadoopi ja Sparki võrdluse alus |

Hadoop |

Säde |

| Kategooria | Põhiline andmetöötlusmootor | Andmeanalüüsi mootor |

| Kasutamine | Partii töötlemine tohutu hulga andmetega | Töötlege reaalajas andmeid reaalajas sündmustest, nagu Twitter, Facebook |

| Latentne aeg | Suure latentsusajaga arvuti | Madala peiteajaga arvutus |

| Andmed | Töötle andmeid pakettrežiimis | Oskab interaktiivselt töödelda |

| Kasutusmugavus | Hadoopi MapReduce'i mudel on keeruline, tuleb käsitleda madala taseme API-sid | Lihtsam kasutada, abstraktsioon võimaldab kasutajal töödelda andmeid kõrgetasemeliste operaatorite abil |

| Planeerija | Vajalik on väline tööplaan | Mälusisene arvutus ei vaja välist ajastajat |

| Turvalisus | Ülimalt turvaline | Vähem turvaline võrreldes Hadoopiga |

| Maksumus | Odavamad, kuna MapReduce'i mudel pakub odavamat strateegiat | Kallim kui Hadoop, kuna sellel on mälusisene lahendus |

Järeldus - Hadoop vs Spark

Hadoop MapReduce võimaldab tohutul hulgal andmeid paralleelselt töödelda. See jaotab suure tüki väiksemateks, mida töödeldakse erinevatel andmesõlmedel eraldi, ja kogub tulemused automaatselt mitme sõlme vahel, et saada üks tulemus. Kui saadud andmestik on saadaolevast RAM-ist suurem, võib Hadoop MapReduce Sparki edestada.

Sparki on seevastu lihtsam kasutada kui Hadoopi, kuna sellega on kaasas kasutajasõbralikud API-liidesed Scala (selle emakeel), Java, Python ja Spark SQL jaoks. Kuna Spark pakub viisi voogesituse, pakkide töötlemise ja masinõppe teostamiseks samas klastris, on kasutajatel lihtne oma andmetöötluse infrastruktuuri lihtsustada.

Lõplik otsus Hadoop vs Spark vahel valida sõltub põhiparameetrist - nõudest. Apache Spark on palju arenenum klastrite arvutusmootor kui Hadoopi MapReduce, kuna see suudab käsitleda igat tüüpi nõudeid, st pakett-, interaktiivset, iteratiivset, voogesitust jne, samal ajal kui Hadoop piirdub ainult pakkimistöötlusega. Samal ajal on Spark oma mälusisese funktsiooniga kallim kui Hadoop, mis nõuab lõpuks palju mälu. Päeva lõpus sõltub kõik ettevõtte eelarvest ja funktsionaalsetest nõuetest. Loodan, et nüüd pidi teil olema mõlemast Hadoop vs Spark õiglasem idee.

Soovitatav artikkel

See on olnud juhis Hadoopi ja Sparki peamistest erinevustest. Siin käsitleme ka Hadoop vs Spark võtme erinevusi infograafikaga ja võrdlustabelit. Võimalik, et leiate lisateabe saamiseks järgmisi Hadoop vs Spark artikleid.

- Andmeladu vs Hadoop

- Splunk vs säde

- Hadoop vs Cassandra - 17 vinge erinevust

- Siga vs säde - kumb on parem

- Hadoop vs SQL jõudlus: erinevus