Ülevaade masinõppe kahjumifunktsioonidest

Nii nagu õpetajad juhendavad meid, hoolimata sellest, kas õpime oma akadeemilistes õppeasutustes hästi või mitte, teevad ka kaotuste funktsioonid sama tööd. See on meetod, mille abil hinnata, kui hästi meie algoritm andmeid modelleerib. Kaasaegses masinõppes on peamiseks hindamisallikaks kaotusfunktsioonid. Kui muudate oma mudeli parendamiseks algoritmi, ütleb kaotusefunktsiooni väärtus teile, kas teete edusamme või mitte. Meie peamine eesmärk peaks olema kaotusfunktsiooni vähendamine optimeerimise teel. Selles artiklis käsitleme kahjumifunktsioonide toimimist ja erinevat tüüpi kadumisfunktsioone.

Kuidas kahjumifunktsioonid toimivad?

Sõna "kaotus" on karistus loodetud tulemuse mittesaavutamise eest. Kui meie mudeli prognoositud väärtuse kõrvalekalle oodatavast väärtusest on suur, siis annab kadude funktsioon väljundina suurema arvu ja kui hälve on väike ja oodatavale väärtusele palju lähemal, väljastab see väiksema arvu.

Siin on näide, kui me proovime ennustada majade müügihinda metropolinnades.

| Ennustatud

Müügihind (lakides) | Tegelik

Müügihind (lakides) | Hälve (kaotus) |

| Bangalore: 45 | 0 (kõik ennustused on õiged) | |

| Pune: 35 | ||

| Chennai: 40 | ||

| Bangalore: 40 | Bangalore: 45 | 5 lakh Bangalore'i ja 2 lakh Chennai jaoks |

| Pune: 35 | Pune: 35 | |

| Chennai: 38 | Chennai: 40 | |

| Bangalore: 43 | 2 lakh Bangalore jaoks, 5 lakh jaoks, Pune2 lakh Chennai jaoks, | |

| Pune: 30 | ||

| Chennai: 45 |

Oluline on märkida, et kõrvalekalde suurusel pole tähtsust, siin on oluline vaid see, kas meie mudeli järgi ennustatud väärtus on õige või vale. Kaotusfunktsioonid on erinevad sõltuvalt teie probleemilausest, millele masinõpet rakendatakse. Kulufunktsioon on veel üks termin, mida kasutatakse kahjumifunktsiooni jaoks vaheldumisi, kuid sellel on pisut erinev tähendus. Kaotuse funktsioon on ühe treeningnäite jaoks, samas kui kulufunktsioon on keskmine kaotus kogu rongi andmestikust.

Kaotamisfunktsioonide tüübid masinõppes

Allpool on toodud erinevad tüüpi kaotusefunktsioonid masinõppes, mis on järgmised:

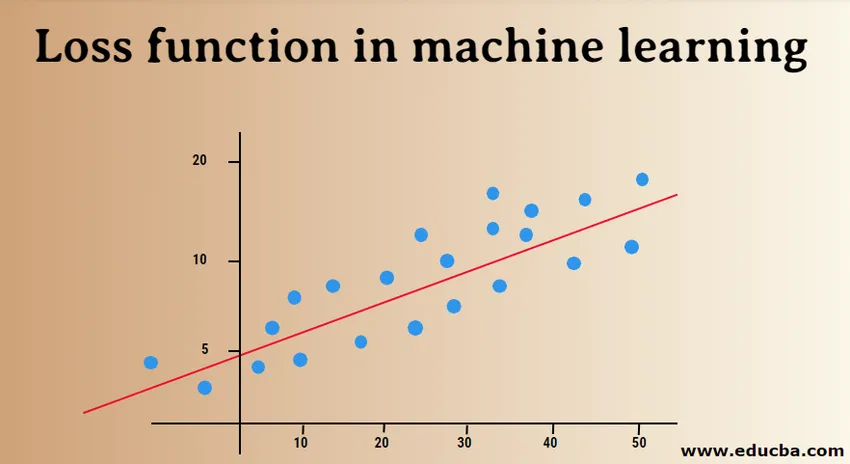

1) Regressioonikaotuse funktsioonid:

Lineaarne regressioon on selle funktsiooni põhikontseptsioon. Regressioonikaotuse funktsioonid loovad lineaarse suhte sõltuva muutuja (Y) ja sõltumatu muutuja (X) vahel, seetõttu proovime nende muutujate jaoks ruumis parimat joont sobitada.

Y = X0 + X1 + X2 + X3 + X4 … + Xn

X = sõltumatud muutujad

Y = sõltuv muutuja

- Keskmine ruutvea kaotus:

MSE (L2 viga) mõõdab mudeli tegelike ja prognoositavate väärtuste keskmist ruutkeskmist erinevust. Väljund on üksikarv, mis on seotud väärtuste komplektiga. Meie eesmärk on vähendada MSE-d, et parandada mudeli täpsust.

Vaatleme lineaarset võrrandit, y = mx + c, saame MSE tuletada järgmiselt:

MSE = 1 / N ∑i = 1 kuni n (y (i) - (mx (i) + b)) 2

Siin on N andmepunktide koguarv, 1 / N ∑i = 1 kuni n on keskmine väärtus ja y (i) on tegelik väärtus ja mx (i) + b selle prognoositud väärtus.

- Keskmine ruutmeetriline logaritmiline veakaotus (MSLE):

MSLE mõõdab suhte tegeliku ja prognoositava väärtuse vahel. See tutvustab veakõveras asümmeetriat. MSLE hoolib ainult tegelike ja ennustatud väärtuste protsentuaalsest erinevusest. See võib olla hea valik kahjumifunktsioonina, kui tahame ennustada majade müügihindu, pagaritoodete müügihindu ja andmeid on pidevalt.

Siin saab kahjumi arvutada logaritmiliselt muundatud tegelike ja ennustatud väärtuste ruutvahe erinevuste vaadeldud andmete keskmisena, mille võib esitada järgmiselt:

L = 1nn∑i = 1 (log (y (i) +1) −log (y (i) +1)) 2

- Keskmine absoluutne viga (MAE):

MAE arvutab tegelike ja prognoositavate muutujate absoluutsete erinevuste summa. See tähendab, et see mõõdab vigade keskmist ulatust ennustatud väärtuste komplektis. Keskmise ruutvea kasutamist on lihtsam lahendada, kuid absoluutse vea kasutamine on tugevam kõrvalnäitajate suhtes. Kõrvalekalded on need väärtused, mis erinevad teistest vaadeldud andmepunktidest väga suurel määral.

MAE võib arvutada järgmiselt:

L = 1nn∑i = 1∣∣y (i) - y (i) ∣∣

2) Binaarse klassifikatsiooni kahjumifunktsioonid:

Need kadude funktsioonid on ette nähtud klassifikatsioonimudeli toimivuse mõõtmiseks. Selles antakse andmepunktidele üks siltidest, st kas 0 või 1. Lisaks saab neid klassifitseerida järgmiselt:

- Binaarne rist-entroopia

See on vaikimisi kaotusfunktsioon binaarsete klassifitseerimisprobleemide jaoks. Rist-entroopia kaotus arvutab klassifikatsioonimudeli toimivuse, mis annab väljundi tõenäosusväärtuse vahemikus 0 kuni 1. Rist-entroopia kaotus suureneb, kui prognoositav tõenäosuse väärtus erineb tegelikust märgistusest.

- Hinge kaotus

Hingekaotust saab kasutada rist-entroopia alternatiivina, mis töötati algselt kasutusele tugivektorimasina algoritmiga. Hingekaotus toimib kõige paremini klassifitseerimisprobleemi korral, kuna sihtväärtused on vahemikus (-1, 1). See võimaldab määrata rohkem vigu, kui tegelike ja ennustatavate väärtuste tähistes on erinevus. Selle tulemuseks on parem jõudlus kui rist-entroopiaga.

- Ruudukujuline liigendikaotus

Hingekao laiendus, mis lihtsalt arvutab hingekao skoori ruudu. See vähendab tõrkefunktsiooni ja muudab selle numbriliselt hõlpsamaks töötamise. See leiab klassifikatsiooni piiri, mis täpsustab maksimaalse marginaali erinevate klasside andmepunktide vahel. Ruudukujuline liigendikadu sobib suurepäraselt JAH või EI mingit tüüpi otsustusprobleemide korral, kus tõenäosuse hälve ei valmista muret.

3) Mitmeklassilise liigituse kaotuse funktsioonid:

Mitmeklassiline klassifikatsioon on ennustavad mudelid, milles andmepunktid on määratud enam kui kahele klassile. Igale klassile antakse kordumatu väärtus vahemikus 0 kuni (arv_klassi - 1). See on väga soovitatav piltide või teksti klassifitseerimise probleemide korral, kui ühel paberil võib olla mitu teemat.

- Mitmeklassiline rist-entroopia

Sel juhul on sihtväärtused vahemikus 0 kuni n, st (0, 1, 2, 3… n). See arvutab skoori, mis võtab tegelike ja prognoositavate tõenäosusväärtuste keskmise erinevuse ning parima võimaliku täpsuse saavutamiseks skoor minimeeritakse. Mitmeklassiline rist-entroopia on tekstiklassifitseerimise probleemide vaikimisi kaotusfunktsioon.

- Hõre mitmeklassiline rist-entroopia

Üks kuum kodeerimisprotsess muudab mitmete klasside rist-entroopia suure hulga andmepunktide käsitlemise keerukaks. Hõre rist-entroopia lahendab selle probleemi, arvutades vea ilma ühe kuuma kodeeringut kasutamata.

- Kullback Leibleri lahknemise kaotus

KL divergentsikaotus arvutab tõenäosusjaotuse ja algtaseme jaotuse vahelise erinevuse ja selgitab välja, kui palju teavet on kadunud bittide osas. Väljund on mittenegatiivne väärtus, mis täpsustab, kui lähedased on kaks tõenäosusjaotust. KL lahknevuse kirjeldamiseks tõenäosusliku vaate osas kasutatakse tõenäosussuhet.

Selles artiklis mõistsime algselt, kuidas kahjumifunktsioonid toimivad, ja siis asusime uurima kadumisfunktsioonide täielikku loetelu koos kasutatud juhtuminäidetega. Selle mõistmine on aga kasulikum, nii et proovige rohkem lugeda ja seda ka rakendada. See selgitab teie kahtlused põhjalikult.

Soovitatavad artiklid

See on juhend masinõppe kaotusfunktsioonide kohta. Siin arutleme, kuidas kahjumifunktsioonid toimivad ja kahjumifunktsioonide tüüpe masinõppes. Võite lisateabe saamiseks vaadata ka järgmisi artikleid -

- Masinõppe meetodid

- Sissejuhatus masinõppesse

- Suurandmete tehnoloogiad

- Suur andmeanalüüsi tarkvara

- Õppige hüperparameetri kategooriaid

- Masinõppe elutsükkel | 8 parimat etappi