Erinevus Väike- ja suurandmed

Väikesed andmed pole midagi muud kui andmed, mis on inimese jaoks piisavalt mahukad ja ka vormindamiseks piisavalt põhjalikud, mis muudab need juurdepääsetavaks, informatiivseks ja kasutatavaks. Traditsioonilises andmetöötluses ei saa käsitleda suuri ega keerulisi andmeid, neid andmeid nimetatakse suurandmeteks. Kui andmemaht kasvab üle teatud piiri, ei piisa traditsioonilistest süsteemidest ja metoodikast, et andmeid töödelda või andmeid kasulikuks vorminguks teisendada. Seetõttu liigitatakse andmed tavaliselt kahte kategooriasse - väikesed andmed vs suured andmed

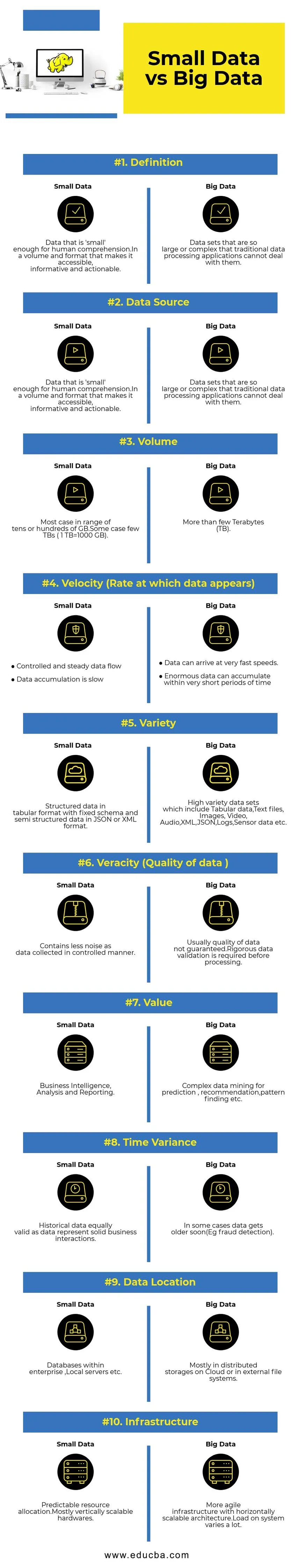

Võrdlus väikeste andmete ja suurte andmete vahel (Infograafika)

Allpool on toodud kümme peamist erinevust väike- ja suurandmete vahel

Peamised erinevused väikeste ja suurte andmete vahel

- Andmete kogumine - tavaliselt on väikesed andmed OLTP-süsteemide osa ja neid kogutakse kontrollitaval viisil ning sisestatakse vahemällu kihti või andmebaasi. Andmebaasid loevad koopiad, et vajaduse korral toetada viivitamatuid analüüsipäringuid. Suurte andmete kogumise torustikus on kiirete andmete tasakaalustamiseks järjekorrad nagu AWS Kinesis või Google Pub / Sub. Allvoolul on reaalajas analüüsi jaoks voogesitustorustikud ja külma andmetöötluse pakkimistööd.

- Andmetöötlus - kuna enamik tehingusüsteemi kaudu genereeritavaid väikesi andmeid on põhiline analüütika enamasti pakettorienteeritud. Mõnel harval juhul jooksevad analüüsiküsimused otse tehingusüsteemide peal. Big Data keskkondades on nii pakk- kui ka voo töötlemistorustikud. Voogu kasutatakse reaalajas analüüsimiseks, näiteks krediitkaardipettuste tuvastamiseks või aktsiahindade ennustamiseks. Pakkide töötlemine, mida kasutatakse keeruka äriloogika rakendamiseks andmete ja täiustatud algoritmidega.

- Skaleeritavus - väikesed andmesüsteemid skaleeruvad tavaliselt vertikaalselt. Vertikaalne skaleerimine suurendab süsteemi läbilaskevõimet, lisades samale masinale rohkem ressursse. Vertikaalne skaleerimine on kulukas, kuid haldamine on vähem keeruline. Suurandmesüsteemid sõltuvad enamasti horisontaalselt skaleeritavast arhitektuurist, mis annab suurema paindlikkuse väiksemate kuludega. Pilves saadaval olevad ennetavad virtuaalsed masinad muudavad horisontaalselt skaleeritavad süsteemid veelgi soodsamaks.

- Andmete modelleerimine - tehingusüsteemidest genereeritud väikesed andmed normaliseeritakse .ETL (Extract Transform Load) andmesidejuhtmed teisendavad need andmelaos tärnide või lumehelveste skeemiks. Siin rakendatakse skeemi alati andmete kirjutamise ajal, mis on suhteliselt lihtne, kuna andmed on paremini struktureeritud. Nagu eespool mainitud, moodustavad tabeliandmed vaid murdosa suurandmetest. Siin korratakse andmeid palju rohkem erinevatel põhjustel, näiteks rikke üleandmisel või aluseks oleva andmebaasi mootori mõningate piirangute tõttu (näiteks toetavad mõned andmebaasid andmestiku kohta ainult ühte sekundaarset indeksit). Skeemi kirjutamisel ei jõustata. Selle asemel valideeritakse skeem andmete lugemise ajal.

- Salvestuse ja arvutuse sidumine - traditsioonilistes andmebaasides, mis enamasti käsitlevad väikeseid andmeid, on salvestus ja arvutamine tihedalt seotud. Andmete sisestamine ja andmebaasi toomine ning andmebaasist väljavõtmine on võimalik ainult antud liidese kaudu. Andmeid ei saa otse andmebaasi failisüsteemi panna või olemasolevate andmete kohta ei saa päringuid teha muude DB mootorite abil. Tegelikult aitab see arhitektuur suuresti tagada andmete terviklikkus. Big Data süsteemidel on salvestuse ja arvutuse vahel väga nõrk ühendus. Tavaliselt salvestatakse andmeid hajutatud andmesalvestussüsteemis, nagu HDFS, AWS S3 või Google GCS, ja arvutatakse mootor andmete pärimiseks või hiljem valitud ETL-i jaoks. Näiteks võib interaktiivseid päringuid täita Presto (Link) ja ETL abil, kasutades samadel andmetel Apache Hive.

- Andmeteadus - masinõppe algoritmid nõuavad sisendandmeid hästi struktureeritud ja õigesti kodeeritud vormingus ning enamasti saadavad sisendandmed mõlemast tehingusüsteemist nagu andmeladu ja suurandmete salvestusest nagu andmejärv. Ainult väikeste andmetega töötavad masinõppe algoritmid on lihtsad, kuna andmete ettevalmistamise etapp on kitsas. Andmete ettevalmistamine ja rikastamine suurandmete keskkonnas võtab palju rohkem aega. Suurandmed pakuvad andmete suure mahu ja mitmekesisuse tõttu arvukalt võimalusi andmeteaduslikuks eksperimenteerimiseks.

- Andmeturve - väikeste andmete turbepraktikad, mis asuvad ettevõtte andmelaos või tehingusüsteemides, mida pakuvad vastavad andmebaasi pakkujad ja mis võivad hõlmata kasutajaõigusi, andmete krüptimist, räsimist jne. Suurte andmesüsteemide turvalisus on palju keerulisem ja väljakutsuvam. Parimad turvalisuse tavad hõlmavad andmete krüptimist puhke- ja transiidi ajal, klastrivõrgu isoleerimist, tugevaid juurdepääsu kontrolli reegleid jne.

Väikeandmete ja suurte andmete võrdlustabel

| Võrdluse alus | Väikesed andmed | Suured andmed |

| Definitsioon | Andmed, mis on inimeste jaoks piisavalt arusaadavad. Mahus ja vormingus, mis muudab need juurdepääsetavaks, informatiivseks ja kasutatavaks | Andmekogumid, mis on nii suured või keerukad, et traditsioonilised andmetöötlusrakendused ei saa nendega hakkama |

| Andmeallikas | ● Andmed traditsioonilistest ettevõttesüsteemidest nagu ○ ettevõtte ressursside kavandamine ○ Kliendisuhete haldus (CRM) ● Finantsandmed nagu pearaamatu andmed ● maksetehingute andmed veebisaidilt | ● Ostuandmed ostukohtadest ● Veebisaitide Clickstreami andmed ● GPS-voo andmed - serverisse saadetavad liikuvuse andmed ● Sotsiaalmeedia - facebook, twitter |

| Maht | Enamik juhtumeid ulatub kümnete või sadade GB-ni. Mõnel juhul on mõni TB (1 TB = 1000 GB). | Rohkem kui paar terabaiti (TB) |

| Kiirus (andmete kuvamise kiirus) | ● Kontrollitud ja püsiv andmevoog ● Andmete kogumine on aeglane | ● Andmed võivad saabuda väga kiiresti. ● Väga lühikese aja jooksul võib koguneda tohutult andmeid |

| Mitmekesisus | Struktureeritud andmed tabelina, fikseeritud skeemina ja poolstruktureeritud andmed JSON- või XML-vormingus | Väga mitmekesised andmekogumid, mis hõlmavad tabeli andmeid, tekstifaile, pilte, videot, heli, XML-i, JSON-i, logisid, anduri andmeid jne. |

| Tõesus (andmete kvaliteet) | Sisaldab vähem müra, kuna kontrollitud viisil kogutud andmeid. | Tavaliselt ei ole andmete kvaliteet tagatud. Enne töötlemist on vaja ranget andmete valideerimist. |

| Väärtus | Äriteave, analüüs ja aruandlus | Kompleksne andmete kaevandamine ennustamiseks, soovituste tegemiseks, mustri leidmiseks jne. |

| Ajavariatsioon | Varasemad andmed, mis kehtivad võrdselt andmetega, tähistavad kindlat ärisuhet | Mõnel juhul vananevad andmed varsti (nt pettuste avastamine). |

| Andmete asukoht | Ettevõttesisesed andmebaasid, kohalikud serverid jne | Enamasti pilve hajutatud hoidlates või välistes failisüsteemides. |

| Infrastruktuur | Prognoositav ressursijaotus.Kõige vertikaalselt skaleeritav riistvara | Horisontaalselt skaleeritava arhitektuuriga paindlikum infrastruktuur. Süsteemi koormus on väga erinev. |

Järeldus - väikesed andmed vs suured andmed

Andmeanalüüsi lõppeesmärk saada otsuste tegemiseks õigeaegseid teadmisi. Andmete liigitamine väikesteks ja suurteks aitab lahendada väljakutseid iga maailma andmete eraldi analüüsimisel sobivate tööriistade abil. Joon kahe kategooria vahel varieerub arenevate täiustatud andmetöötlussüsteemide abil, mis muudab isegi suurte andmete pärimise palju kiiremaks ja vähem keerukaks.

Soovitatavad artiklid:

See on olnud juhend väikeste andmete vs suurandmete kohta, nende tähendus, võrdlus pea vahel, peamised erinevused, võrdlustabel ja järeldus. see artikkel sisaldab kõiki olulisi erinevusi väike- ja suurandmete vahel. Lisateabe saamiseks võite vaadata ka järgmisi artikleid -

- Suurandmed vs andmeteadus - kuidas nad erinevad?

- Suured andmed: oluline on tehnoloogia ja ärianalüütika ühilduvus

- 5 parimat suurandmete suundumust, mida ettevõtted peavad valdama

- 16 huvitavat näpunäidet suurandmete suureks õnnestumiseks