Mis on Apache Hadoopi ökosüsteem?

Apache Hadoopi ökosüsteem on raamistik või avatud lähtekoodiga andmeplatvorm, mis on määratud salvestama ja uurima hiiglaslikke andmekogusid, mis on struktureerimata. Kogu maailmas on liikvel hulgaliselt andmeid arvukatelt digitaalsetelt platvormidelt, millel on juhtiv uuenduslik suurandmete tehnoloogia. Veelgi enam, Apache Hadoop oli esimene, kes selle uuendusvoo sai.

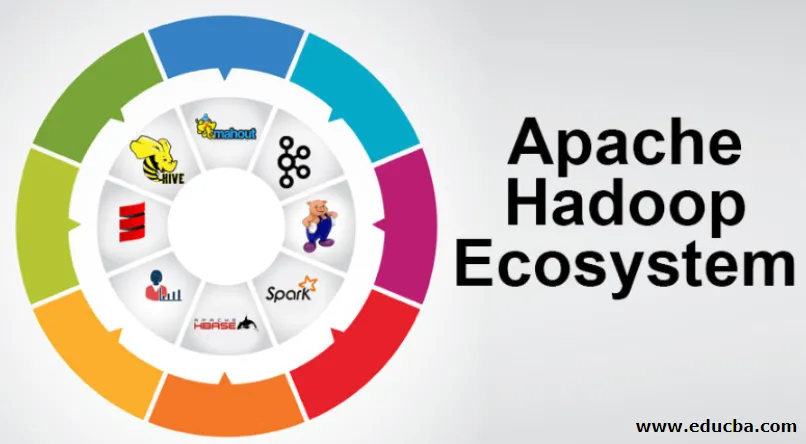

Mis koosneb Hadoop Data arhitektuurist / ökosüsteemist?

Hadoopi ökosüsteem ei ole programmeerimiskeel ega -teenus, see on raamistik või platvorm, mis hoolitseb suurandmete probleemide eest. Saate seda tuvastada komplektina, mis ümbritseb mitmesuguseid teenuseid, näiteks selle sees hoidmine, sissevõtmine, hooldamine ja analüüsimine. Seejärel uurige ja mõelge, kuidas teenused toimivad eranditult ja koostöös. Apache Hadoopi arhitektuur koosneb erinevatest uuendustest ja Hadoopi elementidest, mille kaudu saab isegi keerulisi teabeprobleeme tõhusalt lahendada.

Järgnevalt on kujutatud iga osa:

1) Namenode: see juhib teabeprotsessi

2) Datanode: see komponeerib teabe kohalikku salvestusruumi. Kogu teabe salvestamine ainsasse kohta ei ole alati soovitatav, kuna see võib seisukorra korral põhjustada teabe kaotamise.

3) Ülesande jälgija: nad saavad orjasõlmele määratud ülesanded

4) Kaart: see võtab voost teavet ja iga rida käsitletakse jagamisel, et jagada see eri väljadeks

5) Vähendage: siin kogutakse Mapsi kaudu omandatud väljad või ühendatakse need üksteisega

Apache Hadoopi ökosüsteem - samm-sammult

Hadoopi ökosüsteemi iga element, kuna konkreetsed aspektid on ilmsed. Hadoopi struktuuri terviklik perspektiiv pakub tähelepanuväärset kvaliteeti Hadoopi hajutatud failisüsteemidele (HDFS), Hadoop YARN, Hadoop MapReduce ja Hadoop MapReduce Hadoopi ökosüsteemist. Hadoop annab Hadoopi haldamiseks isegi iga Java raamatukogu, olulised Java kirjed, OS-i taseme peegelduse, eelised ja skriptid. Hadoop YARN on meetod ettevõtte tutvustamiseks ja ressursside hulga haldamiseks. Hadoopi konfiguratsioonis annab HDFS rakendusteabele suure läbilaskevõime ja Hadoop MapReduce annab lõngapõhise paralleelse ettevalmistamise ulatuslikele andmekogudele.

Apache Hadoopi ökosüsteemi ülevaade

Enne Hadoopi ökosüsteemiga töötamist on see oluline mõista. Allpool on toodud olulised komponendid:

- HDFS: see on Hadoopi ökosüsteemi keskosa ja see võib salvestada tohutul hulgal struktureerimata, struktureeritud ja poolstruktureeritud teavet.

- Lõng: See sarnaneb Hadoopi ökosüsteemi mõttega ja kogu käitlemine toimub otse siin, mis võib hõlmata varade jaotamist, töö kavandamist ja meetmete ettevalmistamist.

- MapReduce: see on segu kahest protsessist, mida kirjeldatakse kui Kaardista ja Vähenda ning koosneb sisuliselt osade ettevalmistamisest, mis koosnevad Hadoopi ökosüsteemis paralleelseid ja hajutatud algoritme kasutavatest tohututest infokogumitest.

- Apache Pig: see on protseduurikeel, mida kasutatakse paralleelsete käitlemisrakenduste jaoks Hadoopi tingimustes tohutute infokogumite töötlemiseks ja see keel on Java-programmeerimise võimalus.

- HBase: see on avatud lähtekoodiga ja mitteseotud või NoSQL-i andmebaas. See toetab kõiki teabetüüpe, seega saab Hadoopi raamistikus käsitleda mis tahes tüüpi teavet.

- Mahout, Spark MLib: Mahoutit kasutatakse masinõppes ja see annab olemuse masinõpperakenduste loomiseks.

- Loomaaednik: Rühmadega tegelemiseks võib kasutada loomapidajat. Seda nimetatakse koordinatsiooni isandaks, kes annab Hadoopi kimpude jaoks usaldusväärseid, kiireid ja korrastatud operatiivhaldusi.

- Oozie: Apache Oozie haldab töögraafikut ja töötab häire- ja kellateenusena Hadoopi ökosüsteemis.

- Ambari: See on Apache Software Foundationi ettevõte ja see suudab Hadoopi ökosüsteemi järk-järgult paindlikuks muuta.

Hadoopi lõng:

Mõelge lõngale kui Hadoopi ökosüsteemi mõttele. See mängib läbi kogu teie töötlemistoimingute, määrates varad ja kavandades töökohustusi.

Sellel on kaks tähelepanuväärset segmenti, mis on ResourceManager ja NodeManager.

- ResourceManager: - see on jällegi operatsioonisüsteemi peamine sõlm. See saab ettevalmistavad järelepärimised ja pärast seda edastatakse päringud vastavalt NodeManagereid seotud kohtadele, kus toimub tõeline käitlemine.

- NodeManagers: - need on installitud igasse DataNode. See vastutab ülesande täitmise eest igal DataNode-l.

Kuidas apache Hadoop toimib?

- Kavas on tõusta üksikutest serveritest tohutule hulgale masinatele, pakkudes igaüks kohalikku arvutust ja mahtu. Selle asemel, et sõltuda kõrge ligipääsetavuse edastamise seadmetest, on raamatukogu ise mõeldud pettumuste eristamiseks ja lahendamiseks rakenduste kihis, pakkudes seega erakordselt juurdepääsetavat teenust hunniku personaalarvutite kaudu, millest igaüks võib kalduda pettumustele.

- Vaadake aga kaugemale ja tööl on märkimisväärselt kasvavat võlu. Hadoop on täiesti modulaarne, mis tähendab, et alternatiivse tarkvara jaoks saate selle praktiliselt kõik segmendid välja vahetada. See muudab arhitektuuri fantastiliselt kohandatavaks, sama võimsaks ja tõhusaks.

Apache Hadoopi säde:

- Apache Spark on hajutatud arvutusseadetes reaalajas teabe analüüsimise süsteem. See rakendab mälusiseseid arvutusi, et tõsta teabe töötlemise kiirust.

- Suuremahulise teabe käitlemine on kiirem, kuna kasutab mälusiseseid arvutusi ja erinevaid täiustusi. Nendes ridades nõuab see suurt töötlemisjõudu.

Kuidas Apache Pig töötab?

- Apache Pig on kasulik süsteem Yahoo töötati välja tohutu teabe positsioonide tõhusaks ja sujuvaks uurimiseks. See annab mõne tipptasemel teabevoo keele Pig Latin, mida on täiustatud, laiendatav ja hõlpsasti kasutatav.

- Seaprogrammide erakordne komponent, milles nende koostis on kättesaadav oluliseks paralleelseks muutmiseks, muutes selle lihtsaks oluliste teabekogude eest hoolitsemiseks.

Sigade kasutamise juhtum:

- Üksikisiku isiklik tervishoiuteave on privaatne ja seda ei tohiks teistele inimestele avaldada. Need andmed tuleks saladuse hoidmiseks varjata, kuid meditsiiniteenuseid käsitlev teave on tohutu, et individuaalse tervishoiuteabe äratundmine ja välistamine on hädavajalik. Apache Pig'i saab sellistel tingimustel kasutada terviseandmete dehüdreerimiseks.

Järeldus:

- Välja on pakutud tõusta ainult ühest serverist tohutul hulgal masinaid, mis kõik pakuvad läheduses asuvaid arvutusi ja mahtu. Vaadake aga kaugemale ja tööl on üha enam lummavat.

- Hadoop on täiesti modulaarne, mis tähendab, et alternatiivse tarkvara tööriista jaoks saate selle praktiliselt kõik osad välja kaubelda. See muudab struktuuri fantastiliselt kohandatavaks, sama võimsaks ja tõhusaks.

Soovitatavad artiklid

See on olnud Apache Hadoopi ökosüsteemi juhend. Siin oleme arutanud, mis on Apache Hadoopi ökosüsteem? ülevaade Hadoopi arhitektuurist ja Hadoopi ökosüsteemi toimimisest. Lisateavet leiate ka meie muudest soovitatud artiklitest -

- Hadoopi ökosüsteemi komponendid

- Apache installimine

- Apache sädemete koolitus

- Karjäär Hadoopis