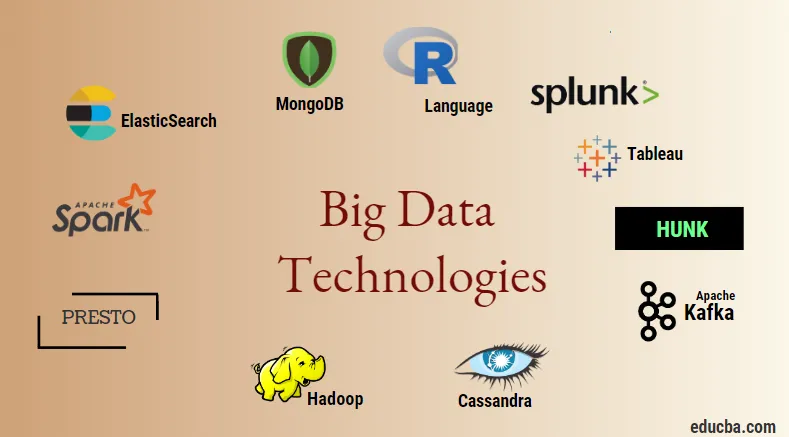

Sissejuhatus suurandmete tehnoloogiasse

Suur andmesidetehnoloogia ja Hadoop on suur sõnad, kuna see võib kõlada. Kuna igas tööstusharus ja valdkonnas on andmete ja teabe valdkond tohutult kasvanud, muutub väga oluliseks luua ja juurutada tõhus meetod, mis hoolitseb andmete genereerimise eest vastutavate klientide ja suurte tööstuste kõigi vajaduste ja nõuete eest. . Kui varem töötasid andmed tavaliste programmeerimiskeelte ja lihtsa struktureeritud päringkeele abil, siis nüüd ei näi need süsteemid ja tööriistad suurandmete korral palju ära teevat. Suurandmete tehnoloogia on tehnoloogia ja tarkvara utiliit, mis on mõeldud teabe analüüsimiseks, töötlemiseks ja ekstraheerimiseks suure hulga äärmiselt keeruka struktuuri ja suurte andmekogumite hulgast, millega on traditsiooniliste süsteemide jaoks väga raske toime tulla. Suurte andmesidetehnoloogiat kasutatakse nii reaalajas kui ka paketiga seotud andmete haldamiseks. Masinõppest on saanud igapäevaelu ja iga tööstuse väga kriitiline komponent ja seetõttu muutub andmete haldamine suurandmete kaudu väga oluliseks.

Suurandmete tehnoloogiate tüübid

Enne tehnoloogialoendiga alustamist vaatame kõigepealt kõigi nende tehnoloogiate laia klassifikatsiooni. Neid saab peamiselt jagada 4 valdkonda.

- Andmekogu

- Analytics

- Andmete kaevandamine

- Visualiseerimine

Vaatame kõigepealt kõiki tehnoloogiaid, mis ladustamise katuse alla kuuluvad.

1. Hadoop : kui tegemist on suurandmetega, on Hadoop esimene tehnoloogia, mis mängu tuleb. See põhineb kaardil vähendaval arhitektuuril ja aitab töötleda pakkimisega seotud töid ning töödelda pakkide teavet. See oli mõeldud andmete hajutatud andmetöötluskeskkonnas hoidmiseks ja töötlemiseks koos kauba riistvara ja lihtsa programmeerimise täitmismudeliga. Seda saab kasutada andmete salvestamiseks ja analüüsimiseks erinevates erinevates seadmetes, millel on suur mälumaht, kiirus ja madalad kulud. See on suurandmetehnoloogia üks põhikomponente, mille arendas välja Apache tarkvara sihtasutus 2011. aastal ja mis on kirjutatud Java keeles.

1. Hadoop : kui tegemist on suurandmetega, on Hadoop esimene tehnoloogia, mis mängu tuleb. See põhineb kaardil vähendaval arhitektuuril ja aitab töötleda pakkimisega seotud töid ning töödelda pakkide teavet. See oli mõeldud andmete hajutatud andmetöötluskeskkonnas hoidmiseks ja töötlemiseks koos kauba riistvara ja lihtsa programmeerimise täitmismudeliga. Seda saab kasutada andmete salvestamiseks ja analüüsimiseks erinevates erinevates seadmetes, millel on suur mälumaht, kiirus ja madalad kulud. See on suurandmetehnoloogia üks põhikomponente, mille arendas välja Apache tarkvara sihtasutus 2011. aastal ja mis on kirjutatud Java keeles.

2. MongoDB : suurandmete säilitamise osas on väga oluline ja põhikomponent MongoDB NoSQL andmebaas. See on NoSQL andmebaas, mis tähendab, et relatsioonilised atribuudid ja muud RDBMS-iga seotud atribuudid selle suhtes ei kehti. See erineb traditsioonilistest RDBMS andmebaasidest, milles kasutatakse struktureeritud päringkeelt. See kasutab skeemidokumente ja ka andmesalvestuse struktuur on erinev ning seetõttu on neist abi suure hulga andmete hoidmisel. See on platvormideülene dokumendile orienteeritud kujundus- ja andmebaasiprogramm, mis kasutab koos skeemiga ka JSON-i dokumente. Sellest saab enamiku finantseerimisasutuste jaoks operatiivsete andmesalvestuste jaoks väga kasulik kasutusjuhtum ja seega traditsiooniliste suurarvutite asendamine. MongoDB töötleb paindlikkust ja ka mitmesuguseid andmetüüpe suurtes kogustes ja hajutatud arhitektuuride vahel.

2. MongoDB : suurandmete säilitamise osas on väga oluline ja põhikomponent MongoDB NoSQL andmebaas. See on NoSQL andmebaas, mis tähendab, et relatsioonilised atribuudid ja muud RDBMS-iga seotud atribuudid selle suhtes ei kehti. See erineb traditsioonilistest RDBMS andmebaasidest, milles kasutatakse struktureeritud päringkeelt. See kasutab skeemidokumente ja ka andmesalvestuse struktuur on erinev ning seetõttu on neist abi suure hulga andmete hoidmisel. See on platvormideülene dokumendile orienteeritud kujundus- ja andmebaasiprogramm, mis kasutab koos skeemiga ka JSON-i dokumente. Sellest saab enamiku finantseerimisasutuste jaoks operatiivsete andmesalvestuste jaoks väga kasulik kasutusjuhtum ja seega traditsiooniliste suurarvutite asendamine. MongoDB töötleb paindlikkust ja ka mitmesuguseid andmetüüpe suurtes kogustes ja hajutatud arhitektuuride vahel.

3. Hunk : see on kasulik andmetele juurdepääsu saamiseks Hadoopi kaugklastrite kaudu, kasutades virtuaalseid indekseid, ning kasutab ka Splunki otsingutöötluskeelt, mida saab kasutada andmete analüüsimiseks. Rummu saab kasutada Hadoopi ja NoSQL andmebaasidest ja allikatest pärinevate tohutul hulgal andmete teatamiseks ja visualiseerimiseks. Selle arendas välja meeskond Splunk aastal 2013, mis kirjutati Java keeles.

3. Hunk : see on kasulik andmetele juurdepääsu saamiseks Hadoopi kaugklastrite kaudu, kasutades virtuaalseid indekseid, ning kasutab ka Splunki otsingutöötluskeelt, mida saab kasutada andmete analüüsimiseks. Rummu saab kasutada Hadoopi ja NoSQL andmebaasidest ja allikatest pärinevate tohutul hulgal andmete teatamiseks ja visualiseerimiseks. Selle arendas välja meeskond Splunk aastal 2013, mis kirjutati Java keeles.

4. Cassandra : Cassandra on populaarseimate NoSQL-i andmebaaside hulgas populaarseim andmebaas, mis on tasuta ja avatud lähtekoodiga andmebaas, mida levitatakse ja millel on lai veergude salvestusruum ning mis suudab tõhusalt käsitleda suurte kaubaklastrite andmeid, st mida kasutatakse. tagama kõrge käideldavuse ja mitte ühegi tõrkepunkti. Põhiomaduste loend sisaldab selliseid nagu hajutatud olemus, mastaapsus, tõrketaluv mehhanism, MapReduce tugi, häälestatav järjepidevus, päringu keele omadus, toetab mitme andmekeskuse replikatsiooni ja võimalikku järjepidevust.

4. Cassandra : Cassandra on populaarseimate NoSQL-i andmebaaside hulgas populaarseim andmebaas, mis on tasuta ja avatud lähtekoodiga andmebaas, mida levitatakse ja millel on lai veergude salvestusruum ning mis suudab tõhusalt käsitleda suurte kaubaklastrite andmeid, st mida kasutatakse. tagama kõrge käideldavuse ja mitte ühegi tõrkepunkti. Põhiomaduste loend sisaldab selliseid nagu hajutatud olemus, mastaapsus, tõrketaluv mehhanism, MapReduce tugi, häälestatav järjepidevus, päringu keele omadus, toetab mitme andmekeskuse replikatsiooni ja võimalikku järjepidevust.

Järgmisena räägime suurandmete tehnoloogia eri valdkondadest, st Data Mining.

5. Presto : see on populaarne avatud lähtekoodiga ja SQL-põhine hajutatud päringumootor, mida kasutatakse interaktiivsete päringute tegemiseks iga skaala andmeallikatega ja suurus ulatub gigabaidist petabaidini. Tema abiga saame päringuid teha Cassandra, Hive, patenteeritud andmehoidlate ja relatsiooniliste andmebaaside salvestussüsteemide kohta. See on Java-põhine päringumootor, mille arendas välja Apache sihtasutus 2013. aastal. Mõned ettevõtted, kes kasutavad Presto tööriista hästi, on Netflix, Airbnb, Checkr, Repro ja facebook.

5. Presto : see on populaarne avatud lähtekoodiga ja SQL-põhine hajutatud päringumootor, mida kasutatakse interaktiivsete päringute tegemiseks iga skaala andmeallikatega ja suurus ulatub gigabaidist petabaidini. Tema abiga saame päringuid teha Cassandra, Hive, patenteeritud andmehoidlate ja relatsiooniliste andmebaaside salvestussüsteemide kohta. See on Java-põhine päringumootor, mille arendas välja Apache sihtasutus 2013. aastal. Mõned ettevõtted, kes kasutavad Presto tööriista hästi, on Netflix, Airbnb, Checkr, Repro ja facebook.

6. ElasticSearch : see on tänapäeval väga oluline tööriist otsimisel. See on ELK-virna oluline komponent, st elastne otsing, Logstash ja Kibana. ElasticSearch on Lucene'i raamatukogudel põhinev otsingumootor, mis sarnaneb Solriga ja mida kasutatakse puhtalt levitatud täistekstiotsingumootori pakkumiseks, mis on võimeline mitme üürniku jaoks. Sellel on loetelu skeemivabadest JSON-dokumentidest ja HTTP-veebiliides. See on kirjutatud JAVA keeles ja selle on välja töötanud Elastic ettevõte ettevõttes 2012. Mõnede elastseid otsinguid kasutavate ettevõtete nimed on järgmised: LinkedIn, StackOverflow, Netflix, facebook, google, Accenture jne.

6. ElasticSearch : see on tänapäeval väga oluline tööriist otsimisel. See on ELK-virna oluline komponent, st elastne otsing, Logstash ja Kibana. ElasticSearch on Lucene'i raamatukogudel põhinev otsingumootor, mis sarnaneb Solriga ja mida kasutatakse puhtalt levitatud täistekstiotsingumootori pakkumiseks, mis on võimeline mitme üürniku jaoks. Sellel on loetelu skeemivabadest JSON-dokumentidest ja HTTP-veebiliides. See on kirjutatud JAVA keeles ja selle on välja töötanud Elastic ettevõte ettevõttes 2012. Mõnede elastseid otsinguid kasutavate ettevõtete nimed on järgmised: LinkedIn, StackOverflow, Netflix, facebook, google, Accenture jne.

Nüüd lugegem kõigi nende suurte andmesidetehnoloogiate kohta, mis on osa andmeanalüütikast:

7. Apache Kafka : tuntud oma publitseerimise-tellimise või pubis-subi järgi, nagu seda rahvapäraselt tuntakse, on otsese sõnumside, asünkroonse sõnumite vahendamise süsteem, mida kasutatakse reaalajas voogesitusandmete andmetöötluseks ja töötlemiseks. Samuti nähakse ette säilitusaeg ja andmeid saab kanaliseerida tootja-tarbija mehhanismi abil. See on üks populaarsemaid voogesitusplatvorme, mis on väga sarnane ettevõtte sõnumsidesüsteemi või sõnumside järjekorraga. Kafka on praeguseks käivitanud mitmeid täiustusi ja üks peamisi liike on Kafka konfluentne, mis pakub Kafkale täiendavaid omadusi nagu Schema register, Ktables, KSql jne. Selle töötas välja Apache Tarkvara kogukond 2011. aastal ja on kirjutatud Java keeles. Ettevõtted, kes seda tehnoloogiat kasutavad, on Twitter, Spotify, Netflix, Linkedin, Yahoo jne.

7. Apache Kafka : tuntud oma publitseerimise-tellimise või pubis-subi järgi, nagu seda rahvapäraselt tuntakse, on otsese sõnumside, asünkroonse sõnumite vahendamise süsteem, mida kasutatakse reaalajas voogesitusandmete andmetöötluseks ja töötlemiseks. Samuti nähakse ette säilitusaeg ja andmeid saab kanaliseerida tootja-tarbija mehhanismi abil. See on üks populaarsemaid voogesitusplatvorme, mis on väga sarnane ettevõtte sõnumsidesüsteemi või sõnumside järjekorraga. Kafka on praeguseks käivitanud mitmeid täiustusi ja üks peamisi liike on Kafka konfluentne, mis pakub Kafkale täiendavaid omadusi nagu Schema register, Ktables, KSql jne. Selle töötas välja Apache Tarkvara kogukond 2011. aastal ja on kirjutatud Java keeles. Ettevõtted, kes seda tehnoloogiat kasutavad, on Twitter, Spotify, Netflix, Linkedin, Yahoo jne.

8. Splunk : Splunkit kasutatakse reaalajas voogesituse andmete hõivamiseks, korrelatsiooniks ja indekseerimiseks otsitavast hoidlast, kust see saab genereerida aruandeid, graafikuid, armatuurlaudu, teateid ja andmete visuaale. Seda kasutatakse ka turvalisuse, vastavuse ja rakenduste haldamise ning ka veebianalüüsi jaoks, ärialaste teadmiste genereerimiseks ja ärianalüüsiks. Selle töötas välja Splunk Pythonis, XML-is, Ajaxis.

8. Splunk : Splunkit kasutatakse reaalajas voogesituse andmete hõivamiseks, korrelatsiooniks ja indekseerimiseks otsitavast hoidlast, kust see saab genereerida aruandeid, graafikuid, armatuurlaudu, teateid ja andmete visuaale. Seda kasutatakse ka turvalisuse, vastavuse ja rakenduste haldamise ning ka veebianalüüsi jaoks, ärialaste teadmiste genereerimiseks ja ärianalüüsiks. Selle töötas välja Splunk Pythonis, XML-is, Ajaxis.

9. Apache Spark : nüüd tuleb kõige kriitilisem ja oodatuim tehnoloogia suurte andmesidetehnoloogiate valdkonnas, st Apache Spark. See on tõenäoliselt üks neist, mis on tänapäeval kõige nõudlikum ja kasutab selle töötlemiseks Java, Scala või Python. Seda kasutatakse reaalajas voogesituse andmete töötlemiseks ja haldamiseks, kasutades sädeme voogesitust, mis selle toimimiseks kasutab pakkimis- ja aknimistoiminguid. Spark SQL-i kasutatakse RDD-de peale andmeraamide, andmekogumite loomiseks ning seeläbi Apache Spark Core'i lahutamatuks osaks olevate transformatsioonide ja toimingute heaks maitsmiseks. Muud komponendid, näiteks Spark Mllib, R ja graphX, on samuti kasulikud analüüside tegemisel ning masinõppe ja andmetöötluse korraldamisel. Mälusisene arvutustehnika eristab seda teistest tööriistadest ja komponentidest ning toetab mitmesuguseid rakendusi. Selle töötas välja peamiselt Java keeles sihtasutus Apache Software.

9. Apache Spark : nüüd tuleb kõige kriitilisem ja oodatuim tehnoloogia suurte andmesidetehnoloogiate valdkonnas, st Apache Spark. See on tõenäoliselt üks neist, mis on tänapäeval kõige nõudlikum ja kasutab selle töötlemiseks Java, Scala või Python. Seda kasutatakse reaalajas voogesituse andmete töötlemiseks ja haldamiseks, kasutades sädeme voogesitust, mis selle toimimiseks kasutab pakkimis- ja aknimistoiminguid. Spark SQL-i kasutatakse RDD-de peale andmeraamide, andmekogumite loomiseks ning seeläbi Apache Spark Core'i lahutamatuks osaks olevate transformatsioonide ja toimingute heaks maitsmiseks. Muud komponendid, näiteks Spark Mllib, R ja graphX, on samuti kasulikud analüüside tegemisel ning masinõppe ja andmetöötluse korraldamisel. Mälusisene arvutustehnika eristab seda teistest tööriistadest ja komponentidest ning toetab mitmesuguseid rakendusi. Selle töötas välja peamiselt Java keeles sihtasutus Apache Software.

10. R-keel : R on programmeerimiskeel ja vaba tarkvaraline keskkond, mida kasutatakse statistiliseks arvutamiseks ja ka graafikas ühes R-i kõige olulisemas keeles. See on üks andmeteadlaste, andmekaevandajate ja andmete praktikud statistilise tarkvara arendamiseks ja peamiselt andmeanalüütika valdkonnas.

10. R-keel : R on programmeerimiskeel ja vaba tarkvaraline keskkond, mida kasutatakse statistiliseks arvutamiseks ja ka graafikas ühes R-i kõige olulisemas keeles. See on üks andmeteadlaste, andmekaevandajate ja andmete praktikud statistilise tarkvara arendamiseks ja peamiselt andmeanalüütika valdkonnas.

Arutagem nüüd andmete visualiseerimisega seotud tehnoloogiaid.

11. Tableau: see on kiireim ja võimsam kasvav andmete visualiseerimise tööriist, mida kasutatakse ärianalüüsi valdkonnas. Andmeanalüüs on väga kiire masin, mis on Tableau abil võimalik ning visualiseerimised luuakse töölehtede ja armatuurlaudade kujul. Selle on välja töötanud tableau ettevõte 2013. aastal ja see on kirjutatud Python, C ++, Java ja C. Tableau kasutavad ettevõtted on: QlikQ, Oracle Hyperion, Cognos jne.

11. Tableau: see on kiireim ja võimsam kasvav andmete visualiseerimise tööriist, mida kasutatakse ärianalüüsi valdkonnas. Andmeanalüüs on väga kiire masin, mis on Tableau abil võimalik ning visualiseerimised luuakse töölehtede ja armatuurlaudade kujul. Selle on välja töötanud tableau ettevõte 2013. aastal ja see on kirjutatud Python, C ++, Java ja C. Tableau kasutavad ettevõtted on: QlikQ, Oracle Hyperion, Cognos jne.

12. Plotly : Plotly kasutatakse peamiselt graafikute ja nendega seotud komponentide kiiremaks ja tõhusamaks muutmiseks. Sellel on rikkalikum raamatukogude ja API-de komplekt, näiteks MATLAB, Python, R, Arduino, Julia jne. Seda saab interaktiivselt kasutada Jupyteri märkmikus ja Pycharmis ning seda saab kasutada interaktiivsete graafikute stiilimiseks. See töötati esmakordselt välja 2012. aastal ja kirjutatud javascripti. Vähesed Plotlyt kasutavad ettevõtted on paladins, bitbank jne.

12. Plotly : Plotly kasutatakse peamiselt graafikute ja nendega seotud komponentide kiiremaks ja tõhusamaks muutmiseks. Sellel on rikkalikum raamatukogude ja API-de komplekt, näiteks MATLAB, Python, R, Arduino, Julia jne. Seda saab interaktiivselt kasutada Jupyteri märkmikus ja Pycharmis ning seda saab kasutada interaktiivsete graafikute stiilimiseks. See töötati esmakordselt välja 2012. aastal ja kirjutatud javascripti. Vähesed Plotlyt kasutavad ettevõtted on paladins, bitbank jne.

Järeldus

Selles postituses oleme uurinud tänapäeval laialdaselt kasutatavaid suurandmete tehnoloogiaid. Loodetavasti meeldis. Järgige meid, et saada rohkem selliseid postitusi.

Soovitatavad artiklid

See on Big Data Technologies juhend. Siin on arutatud suurandmete tehnoloogiate tutvustamist ja tüüpe. Lisateavet leiate ka meie muudest soovitatud artiklitest -

- Mis on Splunk Tool?

- R vs Python

- Mis on Matlab?

- Mis on MongoDB?

- Sammud, mida peate suurarvuti testimisel järgima

- Spark SQL-i liitumiste tüübid (näited)

- Õppige tundma Kafka tööriistade erinevaid tüüpe