Kuidas taru paigaldada?

Apache Hadoop on raamistiku kogum, mis võimaldab klastris levitatud suurandmeid töödelda. Nagu Apache Hive on, on Apache Hadoopi peal üles ehitatud andmelao tarkvara projekt andmete päringute ja analüüside pakkumiseks. Apache taru pakub SQL-i tüüpi liidest suure hulga andmete HQL-le (taru päringute keel) päringu tegemiseks ja töötlemiseks. Apache'i taru töötab Hadoopi ökosüsteemi kohal ja faili kujul salvestatud andmed tähendavad Hadoopi hajutatud failisüsteemi (HDFS). Apache taru pakub kasutajale suurepärase liidese, mis võimaldab andmetele juurde pääseda ja neid tabeli kujul kasutada. See pakub suurepäraseid optimeerimistehnikaid toimivuse paremaks muutmiseks. On väga keeruline teha päring kiiremaks suurte andmete abil ja uskuge mind, see on tootmiskeskkonnas oluline.

Taustaprogrammis teisendab kompilaator HQL-i päringu kaardi vähendamise töökohtadeks ja edastab seejärel Hadoopi raamistikku täitmiseks.

Taru ja SQL-i erinevus

Apache taru on SQL-iga väga sarnane, kuid kuna me teame, et taru töötab Hadoopi ökosüsteemi kohal ja teisendab töökohad sisemiselt MR-i (Map Reduce job), teeb see taru ja SQL-i erinevuse.

Taru poleks parim lähenemisviis nende rakenduste jaoks, kus on vaja väga kiiret reageerimist ja on väga oluline mõista, et taru sobib paremini partiide töötlemiseks väga suurte muutumatute andmete komplektide korral ning peaksime seda tähele panema, et taru on tavaline RDBMS ja viimasena kuid mitte vähem tähtis on afache'i taru lugemisvahendite skeem (andmete tarude tabelisse sisestamisel ei häiri andmetüüpide ebakõla, kuid andmete lugemise korral kuvatakse väärtus nullväärtus, kui andmetüüpi ei vasta konkreetse veeru andmetüübile).

Taru paigaldamise eelnev nõue

Nagu ma juba ütlesin, on väga oluline mõista, et Apache taru jookseb Hadoopi ökosüsteemi kohal ja Hadoop peaks olema valmis ja töötama koos kõigi deemonitega.

Mõned peamised Hadoopi deemonid on järgmised:

- Nimesõlm

- Andmesõlm

- Ressursihaldur

- Sõlmehaldur

Alloleva Hadoopi versiooni kontrollimiseks on käsk:

Tippige käsureale tekst → Hadoopi versioon, mis annab teile Hadoopi versiooni.

Alloleva Hadoopi klastri aruande päästiku kontrollimiseks toimige järgmiselt.

Tippige käsureale käsk → Hadoop dfsadmin –report, see annab teile kogu klastri aruande, kui teie server töötab.

Kui Hadoopi pole teie arvutisse installitud, palutakse teil Hadoopi oma süsteemi installimiseks järgida apache juhiseid.

Loodan, et Java on juba teie süsteemi installitud. java versiooni kontrollimiseks vaadake allolevat ekraanipilti.

Taru installimise sammud Ubuntu

Allpool on toodud sammud Hive'i installimiseks Ubuntule:

1. samm : taru tar, mille saame alla laadida, kasutades terminalis allpool olevat käsku, mille saame otse alla laadida ka terminalist.

Käsk: saame http://archive.apache.org/dist/hive/hive-2.1.0/apache-hive-2.1.0-bin.tar.gz

2. samm : Pakkige tõrvafail, kasutades terminaali allpool asuvat käsku. Saame tõrvata tõrvafaili tarnifaili otse ülevalpool.

Käsk: tar -xzf apache-taru-2.1.0-bin.tar.gz

Ma soovitan teil ekstraheeritud tarufaili kontrollida käsuga ls .

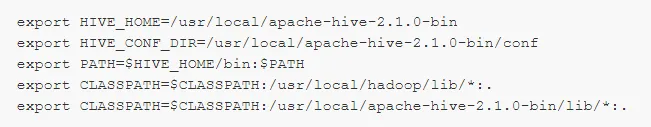

3. samm: muutke faili .bashrc, et kasutaja keskkonnamuutujaid värskendada.

Käsk: sudo .bashrc

Lisage faili lõppu järgmine tekst:

# Määrake HIVE_HOME

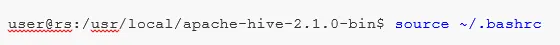

Käivitage allpool antud käsk, et viia lõpule muudatused praeguses terminalis.

Käsk: allikas .bashrc

5. samm : Peame looma tarude kataloogid HDFS-i asukohas ja see kataloog „ladu” on koht, kus hoitakse tarude tabeli metaandmetega seotud teavet ja taruga seotud andmeid.

Käsk :

- hdfs dfs -mkdir -p / kasutaja / taru / ladu

- hdfs dfs -mkdir / tmp

6. samm : Taru tabeli lugemis- ja kirjutamisõiguse seadmiseks täitke käsk allpool.

Käsk:

Allpool asuvas käsus kasutajarühmale kirjutamisõiguse andmine:

- hdfs dfs -chmod g + w / kasutaja / taru / ladu

- hdfs dfs -chmod g + w / tmp

Taru konfigureerimine: Hadoopi abil konfigureerimiseks on taru installimise punkt väga oluline. Peame redigeerima faili hive-env.sh, mis on paigutatud kataloogi $ HIVE_HOME / conf. Järgmised käsud suunavad ümber kausta Hive conf ja kopeerivad mallifaili:

7. samm : Seadistage saidil hive-env.sh Hadoopi tee

Redigeerige faili hive-env.sh, lisades järgmise rea:

Nüüd, kui see protsess on peaaegu valmis ja tarude installeerimine on edukalt lõpule viidud, on oluline seadistada Metastore välise andmebaasiserveriga ja vaikimisi kasutab Apache Hive raamistik Derby andmebaasi. Kasutades allpool käsku Derby andmebaasi initsialiseerimine.

Käsk: bin / schematool -initSchema -dbType derby

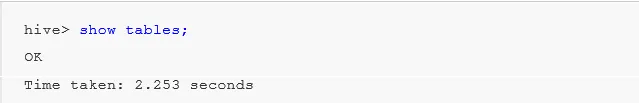

8. samm : käivitage taru .

Käsk: taru (sisestage taru teise taruklemmi terminali sisse.)

Töö taruga: nüüd näeme mõnda tarus tehtud toimingut, et näha, kui palju tabeleid meil vaikeandmebaasis kasutatakse, vaadake allpool olevate ekraanipiltide ekraanipilte: see ei näita ühtegi tabelit tähendab, et meil pole vaikeandmebaasis ühtegi tabelit .

Tarus tabeli loomiseks on väga oluline viidata nõutavale andmebaasile, vastasel juhul luuakse iga tabel vaikeandmebaasi alla.

Tarus olulised käsud

1: kuvage andmebaasid (see näitab kõiki seni loodud andmebaase).

2: looge andmebaas, kui mydb pole, (see käsk loob ühe andmebaasi nimega ' mydb', kui ' mydb' pole olemas ja kui ' mydb on juba olemas, ei anna see ka ühtegi viga')

3: kasutage andmebaasi alati, kui peame konkreetses andmebaasis kasutama mõnda DDl-i käsku. Peaksime kasutama käsku „kasuta andmebaasi”. Meie puhul oleme juba loonud „mydb”. Käsku kasutatakse mydb.

Tähtis käsk Hive DDL

LOE, TÜHJENDA, KORRATA, NÄITA, KIRJELDADA .

- Loo : - andmebaasi loomiseks kasutatava avalduse loomine või tarus tabeli loomine.

Näide: taru> looge andmebaasiettevõte; (andmebaasi loomine)

Taru> kasutage ettevõtet;

Taru> looma laua töötaja (id int, nimi String, palga String); (see loob tabeli töötaja andmebaasi Ettevõtte alla, kuna oleme juba käsku Kasuta andmebaasi kasutanud.)

- Kirjeldus annab teavet tabeli skeemi kohta.

Taru> kirjelda töötajat; (see annab üksikasjaliku skeemi üksikasjad töötajate tabeli kohta)

- TRUNCATE kustutab tabeli andmed.

Taru> kärbitakse laua töötajat;

Saame taru installida ka aknale, kuid parimate tavade jaoks eelistan Ubuntu kasutamist, see annab parema ülevaate produktsiooni keskkonnast ja teie andmeid kasvab tulevikus, seda on lihtne hallata.

Soovitatavad artiklid

See on olnud taru installimise juhend. Siin oleme arutanud Hive'i, DDL-i käsu jms installimise erinevaid samme. Lisateabe saamiseks võite vaadata ka järgmisi artikleid:

- Kuidas installida SQL Server

- Kuidas paigaldada MATLAB

- Taru käsud ja funktsioon

- Põhilised taruvestluse küsimused

- Taruarhitektuur | Töövoog

- Funktsiooni ORDER BY kasutamine tarus

- Tarude paigaldamine