Sissejuhatus andmete eeltöötlemisse masinõppes

Andmete eeltöötlus masinõppes on viis andmete töötlemata kujul teisendamiseks palju vormindatud, kasutamiskõlbmatuks või soovitud vormiks. See on masinõppe lahutamatu ülesanne, mida teostab andmeteadlane. Kuna kogutud andmed on töötlemata vormingus, ei pruugi selle kasutamist mudeli koolitamine võimalik olla. Oluline on neid lähteandmeid hoolikalt töödelda, et neid õigesti tõlgendada ja lõpuks vältida prognoosi negatiivseid tulemusi. Lühidalt, meie õppealgoritmi kvaliteet sõltub suuresti sellest, millist andmestikku me mudeli sisestamiseks kasutasime, nii et selle kvaliteedi säilitamiseks kasutatakse andmete eeltöötlust.

Mudeli koolitamiseks kogutud andmed pärinevad erinevatest allikatest. Need kogutud andmed on tavaliselt töötlemata vormingus, st neil võib olla müra, näiteks puuduvad väärtused, asjakohast teavet, stringi vormingus numbreid jne või need võivad olla struktureerimata. Andmete eeltöötlus suurendab masinõppe mudelite tõhusust ja täpsust. Kuna see aitab need mürad ja andmekogumist eemaldada ning annab andmestikule tähenduse

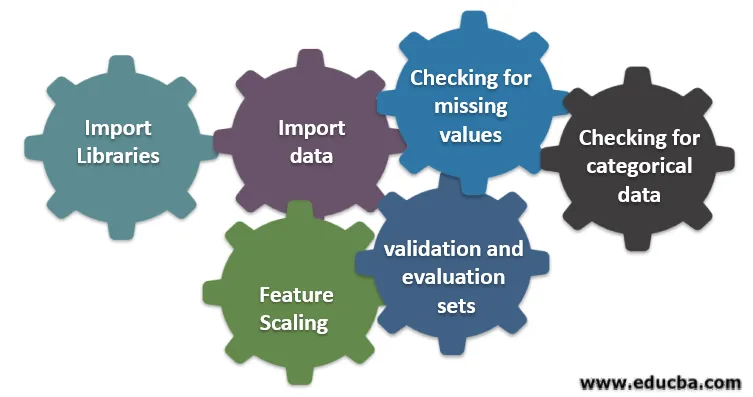

Kuus erinevat masinaõppega seotud sammu

Andmete eeltöötlemise masinõppes osalevad kuus erinevat sammu:

1. samm. Teekide importimine

2. samm: andmete importimine

3. samm: puuduvate väärtuste kontrollimine

4. samm: kategooriliste andmete kontrollimine

5. samm: funktsioonide skaleerimine

6. samm: andmete jagamine koolitus-, valideerimis- ja hindamiskomplektidesse

Mõistame üksikasjalikult kõiki neid samme:

1. Teekide importimine

Kõige esimene samm on importida mõned olulised raamatukogud, mida andmete eeltöötlemisel on vaja. Raamatukogu on moodulite kogu, mida saab helistada ja kasutada. Pythonis on meil palju raamatukogusid, millest on abi andmete eeltöötluses.

Vähesed järgmistest pütoni olulistest raamatukogudest on:

- Tuhm: enamasti kasutatakse raamatukogu masinõppe keeruka matemaatilise arvutuse rakendamiseks või kasutamiseks. See on kasulik toimingu tegemisel mitmemõõtmelistel massiividel.

- Pandas : see on avatud lähtekoodiga raamatukogu, mis pakub suurt jõudlust ja pythonis on hõlpsasti kasutatav andmestruktuur ja andmete analüüsimise tööriistad. See on loodud viisil, mis muudab suhete ja märgistatud andmetega töötamise lihtsaks ja intuitiivseks.

- Matplotlib: see on python'i pakutav visualiseerimiskogu 2D graafikute või massiivi jaoks. See on üles ehitatud tuimale massiivile ja mõeldud töötama laiema Scipy virnaga. Andmekogumite visualiseerimine on abiks stsenaariumi korral, kus on saadaval suuri andmeid. Matplot lib-s saadaval olevad krundid on rida, riba, hajuvus, histogramm jne.

- Seaborn: see on ka pythoni antud visualiseerimiskogu. See pakub kõrgetasemelist liidest atraktiivsete ja informatiivsete statistiliste graafikute joonistamiseks.

2. Impordi andmestik

Kui teegid on imporditud, on meie järgmine samm kogutud andmete laadimine. Nende andmekogumite importimiseks kasutatakse Panda teeki. Enamasti on andmekogumid saadaval CSV-vormingus, kuna need on väikese suurusega, mis teeb töötlemise kiireks. Niisiis, csv-faili laadimiseks panda teegi funktsiooni read_csv abil. Andmekogu võib näha ka mitmesuguseid muid vorminguid

Kui andmestik on laaditud, peame seda kontrollima ja müra otsima. Selleks peame looma funktsiooni maatriksi X ja vaatlusvektori Y X suhtes.

3. Puuduvate väärtuste kontrollimine

Kui olete funktsiooni maatriksi loonud, võite leida mõned puuduvad väärtused. Kui me ei saa sellega hakkama, võib see koolituse ajal probleeme põhjustada.

Puuduvate väärtuste käsitlemiseks on kaks meetodit:

- Eemaldatakse kogu rida, mis sisaldab puuduvat väärtust, kuid võib juhtuda, et võite kaotada osa elutähtsat teavet. See võib olla hea lähenemisviis, kui andmekogumi suurus on suur.

- Kui arvveerul puudub väärtus, saate seda väärtust hinnata keskmise, mediaani, režiimi jne abil.

4. Kategooriliste andmete kontrollimine

Andmekogumi andmed peavad olema arvulises vormis, et neid arvutada. Kuna masinõppe mudelid sisaldavad keerulist matemaatilist arvutust, ei saa me neile anda arvulist väärtust. Seega on oluline teisendada kõik tekstiväärtused arvväärtusteks. Nende kategooriliste väärtuste arvuliseks muutmiseks kasutatakse õpitud klassi LabelEncoder ().

5. Funktsiooni skaleerimine

Algandmete väärtused on väga erinevad ja see võib põhjustada mudeli koolituse kallutatust või suurendada arvutuskulusid. Seega on oluline neid normaliseerida. Funktsioonide skaleerimine on tehnika, mida kasutatakse andmete väärtuse lühendamiseks.

Funktsioonide skaleerimiseks kasutatakse järgmisi meetodeid:

- Kalibreerimine (min-max normaliseerimine)

- Keskmine normaliseerimine

- Standardimine (Z-punkti normaliseerimine)

- Skaleerimine ühiku pikkuse järgi

6. Andmete jagamine koolitus-, valideerimis- ja hindamiskomplektidesse

Lõpuks peame jagama oma andmed kolmeks erinevaks komplektiks: mudeli koolitamiseks mõeldud koolituskomplektiks, meie mudeli täpsuse kinnitamiseks kasutatavaks valideerimise komplektiks ja lõpuks mudeli toimivuse üldiste andmetega testimiseks kasutatavaks komplektiks. Enne andmestiku tükeldamist on kallutatuse vältimiseks oluline see ajada. Ideaalne suhe andmestiku jagamiseks on 60:20:20, st 60% treeningkomplektina, 20% testi- ja valideerimiskomplektina. Andmekogumi jagamiseks kasutage sklearn.model_selectioni üksust train_test_split kaks korda. Üks kord, et jagada andmekogum rongide ja valideerimise komplektiks ning seejärel jagada ülejäänud rongide andmekogum rongideks ja katsekomplektideks.

Järeldus - andmete eeltöötlus masinõppes

Andmete eeltöötlus on midagi, mis nõuab harjutamist. See ei ole nagu lihtne andmestruktuur, kus õpitakse ja rakendatakse vahetult probleemi lahendamiseks. Andmekogumi puhastamise või andmestiku visualiseerimise kohta heade teadmiste saamiseks peate töötama erinevate andmekogumitega.

Mida rohkem neid tehnikaid kasutate, seda parema mõistmise saate sellest. See oli üldine idee, kuidas andmetöötlus mängib olulist rolli masinõppes. Koos sellega oleme näinud ka andmete eeltöötluseks vajalikke samme. Nii et järgmine kord enne kogutud andmete abil mudeli koolitamist alustage kindlasti andmete eeltöötlust.

Soovitatavad artiklid

See on juhend andmete eeltöötluseks masinõppes. Siin käsitleme sissejuhatust, kuus erinevat masinaõppega seotud sammu. Lisateavet leiate ka meie muudest soovitatud artiklitest -

- Tehisintellekti tähtsus

- Interneti-tehnoloogia

- PL / SQL andmetüübid

- Tarude andmete tüübid

- R andmetüübid