Sissejuhatus klassifitseerimise algoritmidesse

See klassifitseerimise algoritme käsitlev artikkel annab ülevaate erinevatest põhimõttest koosnevate andmete kaevandamise tehnikates tavaliselt kasutatavate klassifitseerimismeetodite kohta. Klassifikatsioon on tehnika, mis liigitab andmed kindlale arvule klassidele ja omakorda klassidele omistatakse etikett. Klassifikatsiooni peamine eesmärk on tuvastada klass uute andmete käivitamiseks koolituskomplekti analüüsi abil, nähes õigeid piire. Üldiselt nimetatakse sihtklassi ja ülaltoodud protsessi ennustamist klassifikatsiooniks.

Näiteks registreerib haigla juhtkond patsiendi diagnoosimiseks patsiendi nime, aadressi, vanuse, patsiendi varasema ajaloo, see aitab patsiente klassifitseerida. Neid saab jagada kahte faasi: õppefaas ja hindamisfaas. Õppefaas modelleerib lähenemisbaasi koolitusandmete jaoks, samas kui hindamisetapp ennustab antud andmete väljundit. Nende rakendusi võis leida e-posti rämpspostist, pangalaenu ennustamisest, kõnetuvastusest, sentimentide analüüsist. See tehnika sisaldab matemaatilist funktsiooni f sisendiga X ja väljundiga Y.

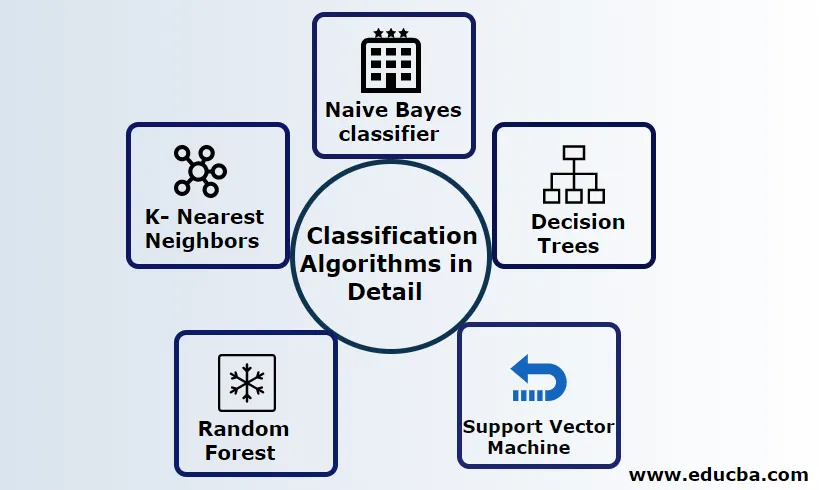

Selgitage üksikasjalikult klassifitseerimise algoritme

Klassifitseerida saab nii struktureeritud kui ka struktureerimata andmetega. Klassifikatsiooni saab liigitada

- Naiivne Bayes klassifikaator

- Otsuse puud

- Tugi vektorimasinale

- Juhuslik mets

- K- lähimad naabrid

1) Naive Bayes klassifikaator

See on Bayesi teoreemil põhinev algoritm, üks statistilistest klassifikaatoritest ja nõuab parameetrite, mida nimetatakse ka tõenäosusklassifikaatoriteks, hindamiseks vähesel hulgal treeningandmeid. Seda peetakse kiireimaks klassifikaatoriks, väga skaleeritavaks ja see haldab nii diskreetset kui ka pidevat teavet. Seda algoritmi kasutati ennustamiseks reaalajas. Seal on erinevat tüüpi naiivseid klassifikaatoreid, Multinomial Naive Bayes, Bernoulli Naive Bayes, Gaussian naiivne.

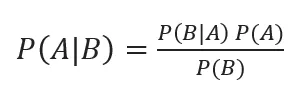

Bayesi klassifikatsioon tagumiste tõenäosustega on esitatud järgmiselt:

Kui A, B on sündmused, P (A | B) - tagumised tõenäosused.

Kui kaks väärtust on teineteisest sõltumatud,

P (A, B) = P (A) P (B)

Naiivseid Bayes saab ehitada python raamatukogu abil. Naiivsete ennustajad on sõltumatud, ehkki neid kasutatakse soovitussüsteemides. Neid kasutatakse paljudes reaalajas rakendustes ja kasutatakse teadlikult dokumentide klassifitseerimisel.

Eelised:

Eelisteks on see, et nad nõuavad väga vähest arvutusvõimsust, eeldades mitme klassi ennustusprobleemides, töötavad täpselt suurte andmekogumite korral.

Puuduseks:

Selle klassifikaatori peamine puudus on see, et nad määravad nulli tõenäosuse. Ja neil on üksteisest sõltumatud omadused.

2) otsustuspuu

See on ülalt alla suunatud lähenemisviis, mille voodiagrammi struktuur haldab kõrgdimensioonilisi andmeid. Tulemusi ennustatakse antud sisendmuutuja põhjal. Järgmistest elementidest koosnev otsustuspuu: juur, paljud sõlmed, oksad, lehed. Juursõlm teeb partitsiooni klassi atribuudi väärtuse alusel, sisemine sõlm võtab atribuudi edasiseks klassifitseerimiseks, harud teevad otsusereegli sõlmede jaotamiseks lehtede sõlmedeks, viimasena annavad lehesõlmed meile lõpptulemuse. Otsustuspuu ajaline keerukus sõltub dokumentide arvust, koolitusandmete atribuutidest. Kui otsustuspuu on liiga pikk, on soovitud tulemusi keeruline saada.

Eelis: neid rakendatakse ennustavas analüüsis probleemide lahendamiseks ja neid kasutatakse igapäevases tegevuses eesmärgi valimiseks otsuse analüüsi põhjal. Ehitab mudeli automaatselt lähteandmete põhjal. Parim puuduvate väärtuste käsitlemisel.

Puuduseks: puu suurus on kontrollimatu, kuni sellel on mingid peatumiskriteeriumid. Puu on nende hierarhilise struktuuri tõttu ebastabiilne.

3) Toetage vektorimasinat

Sellel algoritmil on oluline roll klassifitseerimisprobleemides ja kõige populaarsem on masinõppega juhendatud algoritmid. See on oluline vahend, mida kasutavad teadlane ja andmeteadlane. See SVM on väga lihtne ja selle protsess on hüpertasandi leidmine N-mõõtmelistes kosmose andmepunktides. Hüperplaanid on otsustuspiirid, mis klassifitseerivad andmepunktid. Kogu see vektor langeb hüpertasandile lähemale, maksimeerides klassifikaatori veerise. Kui varu on maksimaalne, on väikseim üldistusviga. Nende rakendamiseks saab kerneli abil kasutada pythonit koos mõne treeningandmekoguga. SVM-i peamine eesmärk on koolitada objekt konkreetsesse klassifikatsiooni. SVM ei ole piiratud, et saada lineaarseks klassifikaatoriks. Nende tuumafunktsiooni tõttu on SVM eelistatud rohkem kui ükski klassifitseerimismudel, mis parandab arvutamise efektiivsust.

Eelis: need on väga eelistatavad väiksema arvutusvõime ja efektiivse täpsuse poolest. Efektiivne kõrgmõõtmelises ruumis, hea mälu tõhusus.

Puuduseks: kiiruse, kerneli ja suuruse piirangud

4) Juhuslik mets

See on võimas masinõppe algoritm, mis põhineb Ensemble'i õppimisviisil. Juhusliku metsa põhielemendiks on otsustuspuu, mida kasutatakse ennustavate mudelite ehitamiseks. Töö demonstratsioon hõlmab juhuslike otsustega puude metsa loomist ja parema tulemuse saamiseks tehakse pügamisprotsess stopp-lõhede seadmisega. Juhuslikku metsa rakendatakse otsuste tegemiseks nimega kottide pakkimine. See kottimine hoiab ära andmete liigse sobitamise, vähendades nihet, nii et see juhuslikkus võib saavutada parema täpsuse. Lõpliku ennustuse võtab keskmiselt paljud otsustuspuud, st sagedased ennustused. Juhuslik mets sisaldab paljusid kasutusjuhtumeid, nagu näiteks aktsiaturu ennustused, pettuste tuvastamine, uudiste ennustused.

Eelised:

- Andmekogumite töötlemiseks pole vaja suurt töötlemist ja väga lihtsa mudeli ehitamine. Pakub suuremat täpsust ennustavate probleemide lahendamisel.

- Töötab hästi puuduvate väärtuste käsitlemisel ja tuvastab automaatselt kõrvaltoime.

Puuduseks:

- Nõuab suuri arvutuskulusid ja palju mälu.

- Nõuab palju rohkem perioodi.

5) K- lähimad naabrid

Siin käsitleme K-NN algoritmi koos juhendatud õppimisega CART-i jaoks. Nad kasutavad K positiivset väikest täisarvu; klass omistatakse klassile naabrite põhjal või öeldakse rühma määramine, jälgides, millises rühmas naaber valetab. Selle valimiseks kasutatakse Eukleidese vahemaa ja jämedat jõudu. K väärtuse saab leida häälestamisprotsessi abil. KNN ei eelista ühegi mudeli õppimist uue andmestiku koolitamiseks ja andmete muutmiseks normaliseerimist.

Eelis: annab tõhusaid tulemusi, kui treeningandmed on tohutud.

Puudus: suurim probleem on see, et kui muutuja on väike, töötab see hästi. Teiseks, K teguri valimine klassifitseerimise ajal.

Järeldus

Kokkuvõtteks võib öelda, et oleme läbinud erinevate klassifitseerimisalgoritmide võimalused ja funktsioneerib endiselt võimsa vahendina funktsioonide väljatöötamisel. Kujutiste klassifitseerimine on suurepärane vahend masinõppe jaoks. Klassifitseerimise algoritmid on võimsad algoritmid, mis lahendavad raskeid probleeme.

Soovitatavad artiklid

See on klassifitseerimise algoritmide juhend masinõppes. Siin arutame, et klassifitseerimist saab teostada nii struktureeritud kui ka struktureerimata andmetega. Võite vaadata ka meie teisi soovitatud artikleid -

- Marsruutimisalgoritmid

- Klasterdamisalgoritm

- Andmete kaevandamise protsess

- Masinõppe algoritmid

- Ansamblite õppimise enim kasutatud tehnikad

- C ++ algoritm | C ++ algoritmi näited