Sissejuhatus masinõppe meetoditesse

Järgmine artikkel Masinõppe meetodid annab ülevaate masinõppes kõige sagedamini kasutatavatest meetoditest. Masinõpe on tehnika, mis võimaldab arvutil iseseisvalt asju "õppida". Algoritmid parandavad adaptiivselt nende jõudlust, kuna õppimiseks saadaolevate andmete arv suureneb. Mida rohkem andmeid, seda täpsem oleks meie mudel.

Kuidas masinad õpivad?

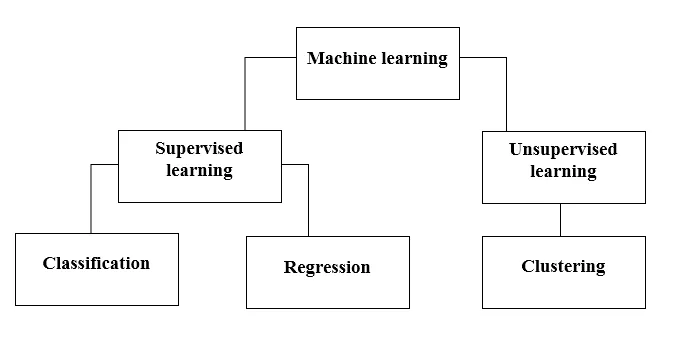

Selleks on erinevaid meetodeid. Millist meetodit täielikult järgida, sõltub probleemi kirjeldusest. Sõltuvalt andmekogumist ja meie probleemist on sügavamale minekuks kaks erinevat viisi. Üks on juhendatud õppimine ja teine juhendamata õppimine. Järgmine tabel selgitab masinõppe meetodite edasist klassifitseerimist. Arutame neid ükshaaval.

Vaadake järgmist diagrammi!

Saame aru, mida tähendab juhendatud õpe.

Juhendatud õppimine

Nagu nimigi ütleb, kujutage ette õpetajat või juhendajat, kes aitaks teil õppida. Sama kehtib ka masinate kohta. Me koolitame või õpetame masinat sildistatud andmete abil.

Mõned lahedamalt juhendatud õpperakendused on:

- Meeleolude analüüs (Twitter, Facebook, Netflix, YouTube jne)

- Looduslik keele töötlemine

- Kujutise klassifikatsioon

- Ennustav analüüs

- Mustrituvastus

- Rämpsposti tuvastamine

- Kõne / jada töötlemine

Nüüd jaguneb juhendatud õpe klassifitseerimiseks ja regressiooniks. Saame sellest aru.

Klassifikatsioon

Klassifikatsioon on mudeli leidmise protsess, mis aitab andmeid jagada erinevatesse kategooriatesse. Selles protsessis liigitatakse andmed erinevate siltide alla vastavalt sisendis antud mõnele parameetrile ja seejärel ennustatakse andmetele silte. Kategooriline tähendab, et väljundmuutuja on kategooria, st punane või must, rämpspost või mitte rämpspost, diabeetiline või mittediabeetiline jne.

Klassifikatsioonimudelite hulka kuuluvad tugivektorimasin (SVM), K-lähim naaber (KNN), Naive Bayes jne.

a) Tugivektorimasina klassifikaator (SVM)

SVM on juhendatud õppemeetod, mis vaatleb andmeid ja sorteerib need kahte kategooriasse. Andmete kategoriseerimiseks kasutan hüpertasandit. Lineaarne diskrimineeriv klassifikaator proovib tõmmata sirget joont, eraldades need kaks andmekogumit ja luua seeläbi klassifitseerimise mudeli. See lihtsalt proovib leida joont või kõverat (kahes mõõtmes) või kollektorit (mitmes mõõtmes), mis klassid teineteisest eraldab.

Märkus . Mitmeklassilise klassifikatsiooni jaoks kasutab SVM väärtust „üks vs puhata”, see tähendab, et iga klassi jaoks arvutatakse erinev SVM.

b) K-lähima naabri klassifikaator (KNN)

- Kui loete hoolikalt, soovitab nimi ise seda, mida algoritm teeb. KNN leiab, et andmepunktid, mis on lähedasemad, on omaduste poolest palju sarnasemad ja kuuluvad seetõttu tõenäolisemalt samasse klassi kui naabrid. Iga uue andmepunkti jaoks arvutatakse kaugus kõigi teiste andmepunktide suhtes ja klass otsustatakse K lähima naabri põhjal. Jah, see võib tunduda lame, kuid mõne klassifikatsiooni puhul töötab see nagu midagi.

- Andmepunkt liigitatakse naabrite maksimaalse häälte arvu järgi, seejärel omistatakse andmepunkt tema k-naabrite seas lähimale klassile.

- KNN-is ei nõuta mudeli õppimist ja kogu töö toimub ennustuse nõudmise ajal. Sellepärast nimetatakse KNN-i sageli laisaks õppimise algoritmiks.

c) Naiivne Bayes'i klassifikaator

- Naiivne Bayes on masinõppe algoritm, mis on teksti klassifitseerimise probleemide korral väga soovitatav. See põhineb Bayesi tõenäosusteoreemil. Neid klassifikaatoreid nimetatakse naiivseteks, kuna nad eeldavad, et tunnusmuutujad on üksteisest sõltumatud. See tähendab, et näiteks meil on sisestamiseks täislause, siis eeldab Naïve Bayes, et lause kõik sõnad on teistest sõltumatud. Ja siis liigitage need vastavalt. Ma tean, see tundub üsna naiivne, kuid see on suurepärane valik teksti klassifitseerimise probleemide jaoks ja see on populaarne valik rämpsposti e-posti aadresside klassifitseerimiseks.

- See pakub erinevat tüüpi Naive Bayes'i algoritme, nagu BernoulliNB, GaussianNB, MultinomialNB.

- Ta peab kõiki funktsioone sõltumatuks, seega ei saa ta tunnuste vahelist suhet õppida. Näiteks, ütleme nii, et Varunile meeldib süüa burgereid, lisaks meeldib talle süüa koksiga friikartuleid. Kuid talle ei meeldi süüa koos burgerit ja friikartulite koos koksiga. Siin ei saa Naiivne Bayes õppida kahe tunnuse suhet, vaid õpib ainult individuaalse tunnuse olulisust.

Liigume nüüd edasi oma juhendatud õppemeetodi teisele küljele, milleks on regressioon.

Regressioon

Regressioon on mudeli leidmise protsess, mis aitab andmeid pidevate väärtuste abil eristada. Selles järjestatakse ennustatavate andmete olemus. Mõned kõige laialdasemalt kasutatavad regressioonimudelid hõlmavad lineaarset regressiooni, juhuslikku metsa (otsustuspuud), närvivõrke.

Lineaarne regressioon

- Üks lihtsamaid lähenemisviise juhendatud õppes, mis on kasulik kvantitatiivse reageerimise ennustamiseks.

- Lineaarne regressioon hõlmab punktidest kõige paremini sirgjoone leidmist. Kõige paremini sobivat joont nimetatakse regressioonijooneks. Kõige sobivam joon ei läbida täpselt kõiki andmepunkte, vaid proovib kõige parem olla neile lähedal.

- See on pidevalt kasutatavate andmete algoritm. Kuid see keskendub ainult sõltuva muutuja keskmisele ja piirdub lineaarse suhtega.

- Lineaarset regressiooni saab kasutada aegridade, trendide prognoosimise jaoks. Selle abil saab eelnevate andmete põhjal ennustada edasist müüki.

Juhendamata õppimine

- Juhendamata õpe põhineb lähenemisel, mida võib pidada õpetaja puudumiseks ja seega ka absoluutseteks veamõõtudeks. See on kasulik, kui see on vajalik elementide rühmitamise või rühmitamise õppimiseks. Elemente saab grupeerida (rühmitada) vastavalt nende sarnasusele.

- Juhendamata õppe korral on andmed sildistamata, neid ei kategoriseerita ja süsteemi algoritmid toimivad andmete suhtes ilma eelneva väljaõppeta. Juhendamata õppealgoritmid võivad täita keerukamaid ülesandeid kui juhendatud õppealgoritmid.

- Juhendamata õppimine hõlmab rühmitamist, mida saab teha kasutades K tähendab rühmitust, hierarhilist, Gaussi segu, varjatud Markovi mudelit.

Juhendamata õpperakendused on:

- Sarnasuse tuvastamine

- Automaatne märgistamine

- Objektide segmenteerimine (nt inimene, loom, filmid)

Klastrid

- Klasterdamine on juhendamata õppemeetod, mida kasutatakse andmete analüüsimisel paljudes valdkondades. Klastrialgoritm on kasulik siis, kui soovime saada üksikasjalikku teavet oma andmete kohta.

- Reaalse maailma näide klastrite moodustamisest oleks Netflixi žanriklastrid, mis jagunevad erinevatele sihtklientidele, sealhulgas huvidele, demograafiale, eluviisidele jne. Nüüd võite mõelda, kui kasulik on klasterdamine, kui ettevõtted tahavad oma kliendibaasi mõista ja uuele potentsiaalile suunata kliendid.

a) K tähendab klastrit

- K tähendab klasterdamisalgoritmi, mis proovib antud tundmatuid andmeid jagada klastriteks. See valib juhuslikult „k” klastri keskpunkti, arvutab andmepunktide ja klastri keskpunkti vahelise vahemaa ning seejärel määrab andmepunkti lõpuks klastri keskpunkti, mille kaugus on klastri keskpunktidest minimaalne.

- K-keskpunktides määratletakse rühmad iga rühma lähima keskpunkti järgi. See tsentroid toimib algoritmi ajus, nad koguvad neile kõige lähedasemad andmepunktid ja lisavad need seejärel klastritesse.

b) Hierarhiline klasterdamine

Hierarhiline klasterdamine on peaaegu sarnane tavalise klastrimisega, kui soovite luua klastrite hierarhiat. See võib olla kasulik, kui soovite otsustada klastrite arvu üle. Oletame näiteks, et loote veebipoes erinevate toodete gruppe. Esileht avalehel soovite paar laia üksust ja kui klõpsate mõnel üksusel, konkreetsed kategooriad, see tähendab konkreetsemad klastrid.

Mõõtmete vähendamine

Mõõtmete vähendamist võib pidada faili tihendamiseks. See tähendab asjakohase teabe väljavõtmist. See vähendab andmete keerukust ja püüab olulisi andmeid säilitada. Näiteks vähendame pildi tihendamisel selle ruumi mõõtmeid, milles pilt püsib, ilma et see hävitaks liiga palju pildi tähenduslikku sisu.

PCA andmete visualiseerimiseks

Põhikomponentide analüüs (PCA) on mõõtmete vähendamise meetod, mis võib olla kasulik teie andmete visualiseerimiseks. PCA-d kasutatakse kõrgemate mõõtmete andmete tihendamiseks madalamate mõõtmetega andmeteks, see tähendab, et PCA abil saame neljamõõtmelised andmed jagada kolmeks või kaheks mõõtmeks, et saaksime andmeid visualiseerida ja neid paremini mõista.

Soovitatavad artiklid

See on masinõppe meetodite juhend. Siin on arutatud sissejuhatust, kuidas masinad õpivad? masinõppe klassifikatsioonid ja vooskeem koos üksikasjaliku selgitusega. Lisateavet leiate ka meie muudest soovitatud artiklitest -

- Masinõppe arhitektuur

- Masinõppe raamistikud

- Masinõppe tööriistad

- Masinõppe tehnikad

- Hüperparameetri masinõpe

- Hierarhiline klasterdamisalgoritm

- Hierarhiline rühmitus | Aglomeratiivne ja lõhestav klasterdamine